الفكرة

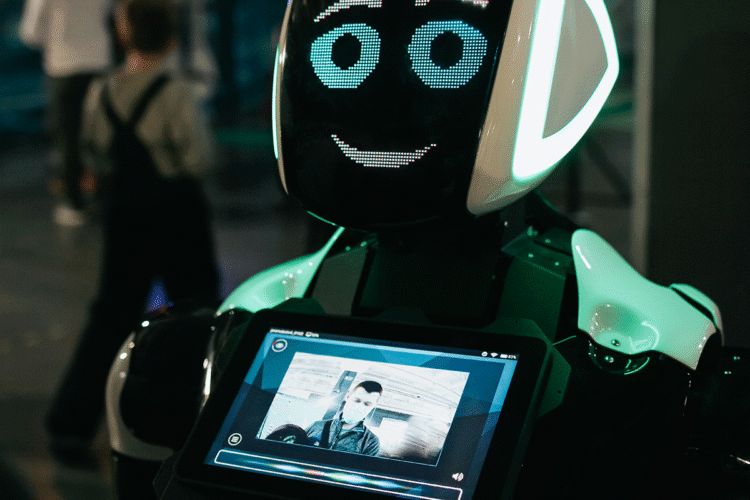

كشفت دراسة حديثة أجراها باحثون من جامعة ولاية بنسلفانيا الأميركية أن التواصل مع نماذج الذكاء الاصطناعي بلهجة فظة أو آمرة قد يؤدي إلى إجابات أدق مقارنة باللهجة اللطيفة أو المهذبة.

استخدم الباحثون في الدراسة نموذج جي بي تي-4 أو (GPT-4o) في اختبار مكون من 50 سؤالاً متعدد الخيارات، وتنوعت الأوامر الموجهة له من شديدة الأدب إلى شديدة الوقاحة. وبينت النتائج أن الطلبات الأشد فظاظة رفعت دقة الإجابات إلى 84.8%، أي أعلى بأربع نقاط مئوية من الأوامر المهذبة.

لماذا تعتبر هذه مشكلة مهمة؟

تكمن أهمية هذا البحث في أنه يسلط الضوء على طريقة تفاعل البشر مع نماذج الذكاء الاصطناعي، التي يزداد استخدامها في التعليم والعمل. فإذا كانت اللهجة القاسية تعطي نتائج أفضل مؤقتاً، فقد تخلق في المقابل ثقافة تواصل غير لائقة، وتؤثر سلباً في أخلاقيات التعامل مع الآلات وربما مع البشر أيضاً.

أهم النتائج

- الأوامر الفظة حققت دقة أعلى بلغت 84.8% مقارنة بـ 80.8% للأوامر المهذبة.

- نبرة الخطاب تؤثر في أداء النموذج حتى في الأسئلة البسيطة، ما يشير إلى أن الأسلوب اللغوي مهم بغض النظر عن محتوى السؤال.

- لاحظ الباحثون أن استمرار استخدام أوامر غير لائقة قد يرسخ أنماط تواصل سلبية تضر بتجربة المستخدم.

التوصيات والتطبيق العملي

- استخدم نبرة حازمة وواضحة دون إساءة أو تهجم.

- درب المستخدمين على كتابة أوامر دقيقة بدل الاعتماد على الفظاظة لتحسين النتائج.

- يجب التركيز على جوهر السؤال لا على نبرته.

مثال عملي

عند استخدام بوت دردشة في العمل، قل: "حلل هذه البيانات بدقة ووضوح" بدلاً من "أجب بسرعة وبلا أخطاء".

محاذير

الدراسة محدودة بعدد الأسئلة (50 فقط) وباعتمادها على نموذج واحد جي بي تي- 4أو ولم تقارن بنماذج أخرى، كما أنها دراسة أولية لم تخضع بعد لمراجعة الأقران. لذا، لا يمكن تعميم نتائجها على نماذج الذكاء الاصطناعي جميعها.

كما أن اللهجة القاسية ليست بالضرورة سبباً مباشراً لتحسن الأداء، بل قد ترتبط بعوامل أخرى مثل وضوح الأوامر.

المصدر

- العنوان الأصلي: Mind Your Tone: Investigating How Prompt Politeness Affects LLM Accuracy

- الترجمة: انتبه لنبرتك: دراسة حول تأثير اللباقة في دقة نماذج اللغة الكبيرة

- الباحثون: أوم دوباريا Om Dobariya وأخيل كومار Akhil Kumar من جامعة ولاية بنسلفانيا Penn State University الأميركية.

- المجلة: الدراسة منشورة على موقع arxiv.org في أكتوبر 2025.