يتمتع الذكاء الاصطناعي بمهارة عالية في التعرف على الأغراض في الصور، إلا أن خداعه والتلاعب به ما زال سهلاً جداً. يكفي أن تضيف بعض التعديلات الفنية المعينة أو تُدرج طبقة من التشويش غير المرئي بالعين المجردة -لكن الآلة تدركه- حتى تتجاوز نظام التعرّف على الصور بكل سهولة.

بل إن هذا التلاعب يكون له في بعض الأحيان أثرٌ مُميت؛ حيث يمكن لإضافة بعض الملصقات إلى لافتة توقُّف مرورية أن تجعل السيارة ذاتية القيادة تظن أن اللافتة تشير إلى تحديد السرعة بـ 70 كيلومتراً في الساعة وليس التوقف. من ناحية أخرى فإن إضافة تلك الملصقات إلى الطريق قد أدى بسيارة تسلا إلى أن تنحرف لتسير في الاتجاه المعاكس. (وطبيعي أن يكون لهذا التلاعب جانب إيجابي، منه على سبيل المثال: حماية المواطنين من المراقبة الحكومية. وهذا ما يعنيه المثل: مصائب قوم عند قوم فوائد).

وجميع ما سبق من عمليات التلاعب بالذكاء الاصطناعي تُعرف بمصطلح "الأمثلة المُربكة"، وفي الوقت الراهن يسعى الكثير من الباحثين والعلماء لتطوير أساليب جديدة لتحصين نُظُم الذكاء الاصطناعي منها. لكن هناك دراسة علمية نُشرت العام الماضي من قِبل فريق من الباحثين لدى مشروع جوجل برين (Google Brain) وجامعة برينستون، من ضمنهم أحد أوائل الباحثين في حقل الأمثلة المربكة: إيان غودفيلو، حيث صرحوا بأن هذا الحقل العلميّ الناشئ نظريٌّ جداً ولا يتجه لحلّ المشكلة فعلياً.

وقالوا إن رُزمة البحوث التي تركز على حماية النُظُم من التلاعبات -المُصممة بشكل خاص لخداع تلك النُظُم- تَغفَل عن حقيقة أن من الممكن لأحد القراصنة الرقميين استخدام حيلة بسيطة للغاية: مجرد صورة مختلفة كلياً، بدلاً من إدراج طبقة تشويش في صورة يعرفها النظام بالفعل. وذلك لأن الصور الجديدة بإمكانها هي أيضاً خداع النظام وجعله يسيء التقدير.

وقد حثّت هذه الانتقادات الباحث دان هندريكس، طالب الدكتوراه في جامعة كاليفورنيا بيركلي، إلى إعداد مجموعة جديدة من الصور؛ حيث سمى الصور التي تحتويها المجموعة بـ "الأمثلة المُربكة الطبيعية"، وهي صور قادرة على خداع نظام الذكاء الاصطناعي دون تضمين أي تعديلات خاصة أو لمسات فنية معينة فيها.

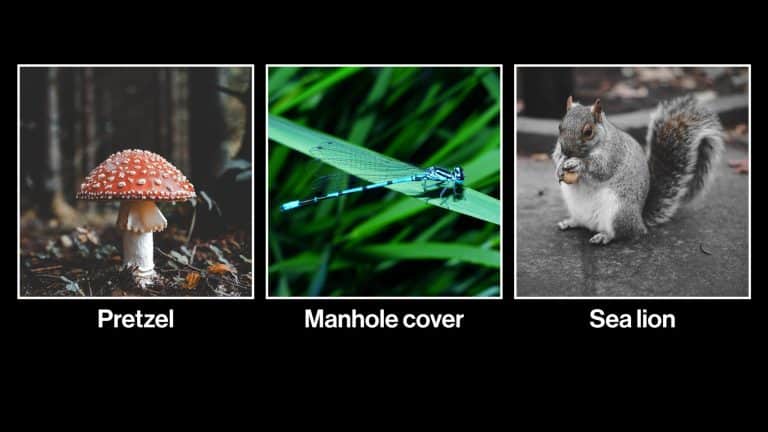

وتحتوي هذه المجموعة صوراً مثل صورة السنجاب التي تُخطئ نُظُم الذكاء الشائعة بتصنيفه على أنه أسد بحر، وصورة اليعسوب التي تخطئ النظم بتصنيفه على أنه غطاء فتحة الدخول الذي غالباً ما نراه في أرضية الشوارع. وفي هذا السياق، يقول الباحث: "إن تحصين نُظُم الذكاء ضد هذه الأمثلة أصعب بكثير من تحصينها ضد الأمثلة المُعدّلة". وذلك لأن صانع "الأمثلة المربكة المُعدّلة" لا بد أن يكون على دراية بكافة الأساليب الدفاعية التي ينتهجها نظام الذكاء الاصطناعي لكيّ تكون صوره فعالة جداً في خداع النظام. في حين أن الأمثلة المربكة الطبيعية تنجح في خداع نُظُم الذكاء الاصطناعي حتى عندما تُحدِّث تلك النظم دفاعاتها أو تغيّرها.

وفي هذا السياق، كشف الباحث هندريكس الأسبوع الماضي في المؤتمر الدولي لتعلم الآلة، عن نسخة أولية من هذه المجموعة من الصور، تضم نحو 6,000 صورة. هذا ويعتزم الباحث هندريكس إصدار نسخة نهائية تضم نحو 8,000 صورة في غضون بضعة أسابيع من الآن. ويهدف الباحث هندريكس من إتاحته هذه المجموعة في متناول الباحثين أن يستخدموها كمعيار مرجعيّ (أساسٍ للمقارنة) في دراساتهم.

بعبارة أخرى، فإن الباحث هندريكس يريد من العلماء ألا يستعملوا هذه الصور إلا في الاختبار، بدلاً من أن يتخذوها هي ذاتها مادةً لتدريب نُظم التعرف على الصور. ويفسّر الباحث ذلك بقوله: "إذا استخدم الناس هذه المجموعة من الصور في التدريب، فلن تُحلّ مشكلة الأمثلة المربكة، فبالرغم من أن نُظُم الذكاء لن تنخدع بتلك الصور لأنها تدربت عليها، إلا أن ذلك لن يحلّ المسألة؛ حيث سينخدع النظام بغيرها من الصور المربكة الجديدة التي لم يتدرب عليها".

وبالتالي فإن استخدام المجموعة المرجعية في الاختبار وليس التدريب سيؤدي إلى استكشاف أسباب ارتكاب النظام الذكي للأخطاء عندما نعرض عليه بعض الأمثلة المُربكة، ومن ثَم يمكن جعل النُظُم الذكية أكثر حصانة ضدها. ويختتم هندريكس كلامه مازحاً بقوله: "كيف يمكن أصلاً خلط اليعسوب بوجبة واكامولي المكسيكية؟ إن سبب ارتكاب هذا الخلط ما زال يحيّرني حتى الآن".