يبدو أن تحيز الخوارزميات وصل إلى فيسبوك.

مؤخراً، تم توجيه دعوى قضائية إلى الشركة التكنولوجية العملاقة من قبل وزارة الإسكان والتطوير الحضري الأميركية، وذلك لأنها تسمح للمعلنين بتوجيه إعلاناتهم إلى المستخدمين، وبشكل متعمد، وفق العرق والجنس والدين، وجميعها فئات محمية وفق القانون الأميركي. وقد أعلنت الشركة أنها ستتوقف عن هذا.

ولكن توجد أدلة جديدة تشير إلى أن خوارزمية فيسبوك، والتي تقرر آلياً من سيرى الإعلان، تحمل نفس الطابع التمييزي على أي حال، بحيث تعرض الإعلانات على مستخدمي الموقع الذين يربو عددهم على المليارين على أساس معلوماتهم الديموغرافية.

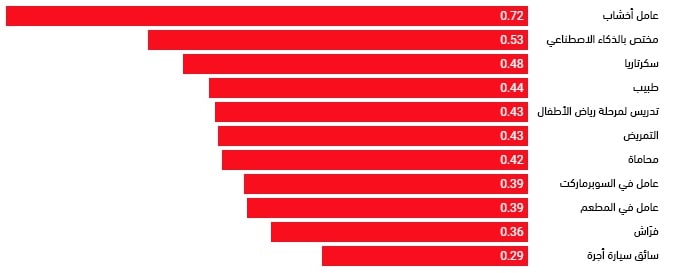

أجرى فريق بحثي بقيادة محمد علي وبيوتر سابييزينسكي في جامعة نورث إيسترن اختبارات على مجموعة من الإعلانات شبه المتطابقة، والتي توجد بينها اختلافات بسيطة في الميزانية المتوافرة، أو العنوان الرئيسي، أو النص، أو الصورة. ووجدوا أن هذه التباينات الطفيفة أثرت بشكل كبير على نوعية الجمهور الذي وصل إليه الإعلان، خصوصاً في إعلانات التوظيف أو العقارات. وعلى سبيل المثال، فإن إعلانات العمل في التدريس في رياض الأطفال والسكرتاريا كانت تظهر للنساء بنسبة أكبر، على حين أن إعلانات العمل للفراشين وسائقي سيارات الأجرة كانت تظهر للأقليات بنسبة أكبر. وكانت إعلانات بيع المنازل تظهر بنسبة أكبر للمستخدمين من العرق الأبيض، على حين أن إعلانات تأجير المنازل كانت تظهر بنسبة أكبر للأقليات.

إعلانات التوظيف للفراشين وسائقي سيارات الأجرة ظهرت بنسبة أكبر لدى الأقليات:

نسبة المستخدمين من العرق الأبيض في حضور الإعلان

قال متحدث باسم فيسبوك في تصريح للرد على هذه النتائج: "لقد أجرينا تعديلات جذرية على أدواتنا للإعلان الموجه، وندرك أن هذه ليست سوى الخطوة الأولى وحسب. لقد كنا ندرس نظام عرض الإعلانات، وقد تفاعلنا حول هذا الموضوع مع أهم الشخصيات في المجال التكنولوجي، والأكاديميين، وخبراء الحقوق المدنية، ونحن ندرس المزيد من التغييرات".

من وجهة نظر معينة، فإن هذا ليس مصدر مفاجأة، حيث أن التحيز في أنظمة التوصية مسألة معروفة منذ عدة سنوات. وعلى سبيل المثال، نشرت لاتانيا سويني -وهي بروفسورة مختصة بالحكومة والتكنولوجيا في هارفارد- بحثاً في 2013 يبين التمييز العنصري الضمني لخوارزمية جوجل لعرض الإعلانات. وتعود هذه المسألة إلى أساسيات عمل هذه الخوارزميات، حيث أنها جميعاً مبنية على التعلم الآلي، والذي يعني بالبحث عن الأنماط في كميات هائلة من البيانات، ويعيد تطبيقها لاتخاذ القرارات. وهناك الكثير من الأساليب التي يمكن أن يتسرب بها التحيز عبر هذه العملية، ولكن كما يبدو، فإن أهم طريقتين في حالة فيسبوك تتعلقان بمشاكل في تأطير المشكلة وجمع البيانات.

يحدث التحيز خلال تأطير المشكلة عندما يصبح هدف نموذج التعلم الآلي غير متوافق مع الحاجة إلى تجنب التمييز. حيث أن أداة فيسبوك الإعلانية تسمح للمعلنين باختيار أحد ثلاثة أهداف للأَمثَلة: عدد مرات عرض الإعلان، عدد النقرات ومقدار التفاعل الذي يتلقاه، وكمية المبيعات التي يولدها. ولكن هذه الأهداف العملية الثلاثة لا تتعلق على الإطلاق بالمحافظة على المساواة في الإسكان مثلاً. ولهذا، إذا اكتشفت الخوارزمية أنها يمكن أن تزيد من التفاعل عن طريق عرض إعلانات شراء المنازل على عدد أكبر من المستخدمين من العرق الأبيض، فسوف ينتهي بها الأمر إلى أن تتحيز ضد المستخدمين من ذوي البشرة السمراء.

تظهر إعلانات شراء المنازل لنسبة أكبر من المستخدمين من العرق الأبيض:

نسبة المستخدمين من العرق الأبيض في حضور الإعلان

الشكل البياني: إم آي تي تكنولوجي ريفيو. المصدر: علي وسابييزينسكي وآخرون. تم بناء الشكل باستخدام داتا رابر.

يحدث التمييز خلال جمع البيانات عندما تعكس بيانات التدريب التحيز الموجود واقعياً. حيث أن خوارزمية فيسبوك تبني أًمثَلة القرارات على البيانات السابقة للناس. فإذا تفاعلت الأقليات مع إعلانات تأجير المنازل بنسبة أكبر في الماضي، سيتعرف نموذج التعلم الآلي على هذا النموذج ويعيد تطبيقه بشكل دائم. ومرة أخرى، سيعمل بشكل أعمى على تمهيد الطريق أمام التمييز في التوظيف والإسكان، بدون أن يُطلب منه ذلك بشكل مباشر.

على الرغم من أن هذه ليست أول مرة تُدرس فيها هذه السلوكيات في التعلم الآلي، فإن هذه الدراسة الجديدة تقدم نظرة مباشرة على مدى تأثير هذه المشكلة على إمكانية حصول الناس على فرص الإسكان والتوظيف. يقول كريستيان ساندفيج، مدير مركز الأخلاقيات والمجتمع والحوسبة في جامعة ميشيغان، لمجلة ذا إيكونوميست: "إن هذه النتائج هائلة التأثير. لأن هذا البحث يخبرنا أن استخدام البيانات الكبيرة بهذه الطريقة لن يقدم لنا عالماً أفضل. وفي الواقع، فمن المحتمل أن هذه الأنظمة تجعل العالم أسوأ عن طريق مفاقمة المشاكل التي تؤدي إلى الظلم والتمييز".

أما الأخبار الجيدة فهي أنه قد توجد وسائل لمعالجة هذه المشكلة، ولكن لن يكون الأمر بهذه السهولة. ويعمل الكثير من باحثي الذكاء الاصطناعي حالياً على حلول تقنية لتحيز التعلم الآلي لبناء نماذج أقل تحيزاً للإعلانات على الإنترنت. وعلى سبيل المثال، يشير بحث جديد من جامعة يال والمعهد الهندي للتكنولوجيا إلى أنه يمكننا أن نفرض قيوداً على الخوارزميات للتخفيف من السلوك المتحيز، ولكن على حساب دخل الإعلان. غير أنه يتوجب على صانعي السياسات أن يلعبوا دوراً أكبر إذا بدأت المنصات بالاعتماد على هذه الحلول، خصوصاً إذا كانت ستؤثر على عائداتها.