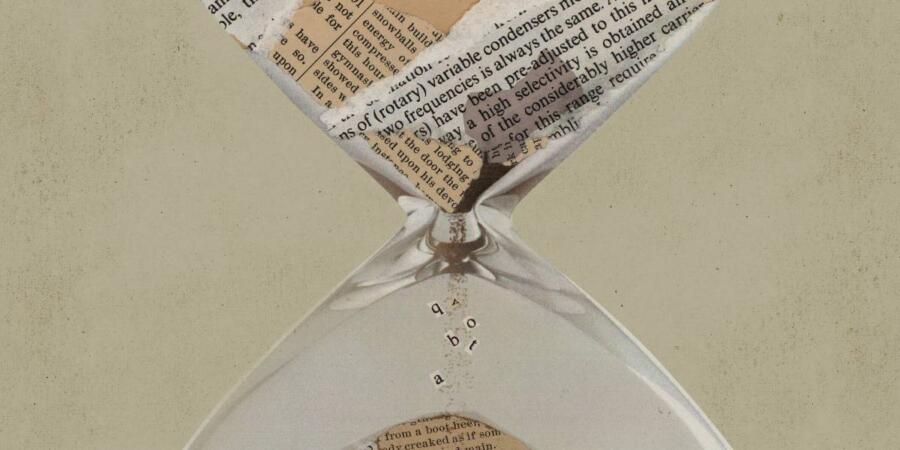

تمثل النماذج اللغوية الكبيرة أحد أكثر مجالات أبحاث الذكاء الاصطناعي شعبية في الوقت الحالي، حيث تتسابق الشركات لإطلاق برامج مثل جي بي تي 3 (GPT3) الذي يستطيع كتابة مقالات بصياغة ممتازة، بل وحتى كتابة التعليمات البرمجية الحاسوبية. ولكن هناك مشكلة تلوح في الأفق، وفقاً لفريق من مستشرفي الذكاء الاصطناعي، فقد تنفد البيانات الضرورية لتدريبها.

كيف يتم تدريب النماذج اللغوية الكبيرة؟

يتم تدريب النماذج اللغوية باستخدام نصوص من مصادر مثل ويكيبيديا (Wikipedia)، والمقالات الإخبارية، والأوراق البحثية العلمية، والكتب. وفي السنوات الأخيرة، كان النمط السائد يتلخص بتدريب هذه النماذج على المزيد والمزيد من البيانات على أمل زيادة دقتها وتنوع قدراتها.

وتكمن المشكلة في أن أنواع البيانات المستخدمة عادة لتدريب النماذج اللغوية قد يتم استهلاكها في المستقبل القريب، ربما في عام 2026، وذلك وفقاً لورقة بحثية نشرها باحثون من مؤسسة إيبوك (Epoch) لأبحاث واستشراف الذكاء الاصطناعي. وتتلخص المشكلة في أن الباحثين أصبحوا في حاجة إلى إيجاد المزيد من النصوص لبناء نماذج بقدرات أكبر وفعالية أكبر وتدريبها. ويشعر باحثو النماذج اللغوية الكبيرة بقلق متزايد من نفاد هذا النوع من البيانات، كما يقول تيفين لي ساكو، وهو باحث في شركة الذكاء الاصطناعي هاغينغ فيس (Hugging Face)، وليس من المشاركين في عمل إيبوك.

اقرأ أيضاً: لماذا لم يصمد أحدث النماذج اللغوية الكبيرة من ميتا على الإنترنت أكثر من 3 أيام؟

مشكلة توافر بيانات تدريب النماذج اللغوية الكبيرة

وتنبع المشكلة جزئياً من قيام باحثي أنظمة الذكاء الاصطناعي اللغوية بفلترة البيانات التي يستخدمونها لتدريب النماذج إلى فئتين: عالية الجودة ومنخفضة الجودة. ولكن الحد الفاصل بين الصنفين قد يكون غير واضح، كما يقول بابلو فيلالوبوس، وهو باحث عامل في إيبوك، والمؤلف الأساسي للورقة البحثية، ولكن النصوص من النوع الأول عادةً ما تكون أفضل صياغة، وهي من إنتاج كتّاب محترفين في أغلب الأحيان.

أما البيانات التي تنتمي إلى الفئة منخفضة الجودة فتتألف من نصوص مثل منشورات مواقع التواصل الاجتماعي، أو التعليقات على مواقع ويب مثل 4chan، وهي تتفوق على البيانات عالية الجودة من حيث الكمية بعدة أضعاف. يقوم الباحثون عادة بتدريب النماذج باستخدام البيانات عالية الجودة فقط، لأنهم يرغبون بأن تقوم النماذج اللغوية بصياغة نتائج مماثلة. وقد أدت هذه الطريقة إلى بعض النتائج الرائعة للنماذج اللغوية الكبيرة، مثل جي بي تي 3.

وقد يكون من الممكن تجاوز قيود البيانات بإعادة تقييم تعريف الجودة "المنخفضة" و"العالية"، وذلك وفقاً لسوابا سوايامديبتا، أستاذة التعلم الآلي في جامعة ساوثرن كاليفورنيا، والمختصة بجودة قواعد البيانات. فإذا دفع نقص البيانات بباحثي الذكاء الاصطناعي إلى استخدام مجموعات بيانات أكثر تنوعاً في عملية التدريب، فسوف يكون هذا "عاملاً إيجابياً بصورة كاملة" للنماذج اللغوية، كما تقول سوايامديبتا.

اقرأ أيضاً: هل تمثل النماذج اللغوية مثل جي بي تي 3 بداية نوع جديد من محركات البحث؟

كما قد يجد الباحثون أساليب أخرى لاستثمار البيانات بشكل أفضل لتدريب النماذج اللغوية. وفي الوقت الحالي، يتم تدريب النماذج اللغوية على نفس البيانات مرة واحدة، نظراً لبعض القيود المتعلقة بالأداء والتكاليف. ولكن، قد يكون من الممكن تدريب نفس النموذج عدة مرات باستخدام نفس البيانات، كما تقول سوايامديبتا.

ويعتقد بعض الباحثين أن زيادة كمية البيانات لا تقتضي بالضرورة الحصول على نتائج أفضل في النماذج اللغوية على أي حال. ويقول بيرسي ليانغ، أستاذ علوم الحاسوب في جامعة ستانفورد، إن الأدلة تشير إلى أن جعل النماذج أكثر فعالية، بدلاً من زيادة حجمها وحسب، قد يحسّن من قدراتها. وكما يشرح: "لقد رأينا كيف تستطيع النماذج الصغيرة المدربة على بيانات أكثر جودة أن تتفوق في الأداء على النماذج الضخمة المدربة على بيانات أقل جودة".