كانت وظيفة رومان شودري تنطوي عادة على الكثير من الترجمة، وبصفتها قائدة “الذكاء الاصطناعي المسؤول” في شركة الاستشارات أكسنتشر، كانت تعمل مع العملاء الذين يواجهون صعوبات في فهم نماذج الذكاء الاصطناعي الخاصة بهم. كانوا يتساءلون عن كيفية معرفة ما إذا كانت هذه النماذج تؤدي الوظيفة التي يفترض بها تأديتها أم لا. وقد كان السبب جزئياً وراء هذا الارتباك يعود في الغالب إلى أن علماء البيانات والمحامين والمدراء التنفيذيين بالشركة يتحدثون إلى بعضهم بلغات مختلفة على ما يبدو. وكان فريقها يلعب دور حلقة الوصل بين جميع الأطراف حتى تتمكن من التفاهم فيما بينها والتحدث بلغة مشتركة. وكان أقل ما يمكن أن يوصف به أداء الفريق هو أنه غير فعال؛ حيث إن تدقيق نموذج واحد قد يستغرق شهوراً.

لذلك في أواخر عام 2020، تركت شودري منصبها لتطلق شركتها الناشئة الخاصة. تحمل هذه الشركة اسم باريتي إيه آي (Parity AI)، وتقدم للعملاء مجموعة من الأدوات التي تسعى لتقليص المدة التي تستغرقها عملية تدقيق النماذج إلى بضعة أسابيع. فهي تساعدهم أولاً في تحديد الكيفية التي يريدون بها تدقيق نموذجهم -هل يرغبون في التحقق مما إذا متحيزاً أو التأكد من درجة امتثاله للقوانين؟- ثم تقدم توصيات لمعالجة المشكلة.

تعد شركة باريتي من بين مجموعة متزايدة من الشركات الناشئة التي توفر للشركات طرقاً واعدة لتطوير نماذج الذكاء الاصطناعي الخاصة بها ومراقبتها وإصلاحها. وتقدم هذه الشركات مجموعة من المنتجات والخدمات، بدءاً من أدوات التخفيف من التحيز ووصولاً إلى منصات قابلية النماذج للتفسير.

في البداية، كان معظم عملاء هذه الشركات الناشئة من قطاعات شديدة التنظيم مثل القطاع المالي وقطاع الرعاية الصحية، لكن زيادة الأبحاث وتنامي اهتمام وسائل الإعلام بشأن قضايا التحيز والخصوصية والشفافية قد أحدثت تحولاً في نوعية العملاء. غالباً ما يشعر العملاء الجدد بالقلق ببساطة من كونهم مسؤولين، بينما يريد الآخرون امتلاك “إمكانات صالحة للعمل في المستقبل” تحسباً لتبدل السياسات واللوائح التنظيمية.

تقول شودري: “تواجه العديد من الشركات هذا التحدي بالفعل للمرة الأولى. وفي الواقع، جميعهم تقريباً يطلبون بعض المساعدة”.

من تخفيف المخاطر إلى دراسة التأثير

عند العمل مع عملاء جدد، تتجنب شودري استخدام مصطلح “المسؤولية”؛ إذ إنه مصطلح فضفاض للغاية وغير واضح المعالم، وبالتالي يفسح مجالاً كبيراً لسوء الفهم والتواصل. وبدلاً من ذلك، تبدأ معهم بمصطلح مألوف في عالم الشركات: فكرة المخاطر. فالعديد من الشركات تمتلك أقساماً خاصة بالمخاطر والامتثال، وعمليات راسخة لتخفيف المخاطر.

وفي هذا الصدد، فإن التخفيف من مخاطر الذكاء الاصطناعي لا يختلف كثيراً. يجب أن تبدأ الشركة بالتفكير في الجوانب المختلفة التي تقلقها مثل المخاطر القانونية؛ أي احتمال خرق القانون، أو المخاطر التنظيمية؛ أي إمكانية فقدان الموظفين، أو مخاطر الإضرار بالسمعة؛ أي احتمال التعرض لكارثة علاقات عامة. وانطلاقاً من التفكير في هذه المخاطر، يمكن للشركة العمل بشكل عكسي لتقرير كيفية تدقيق أنظمة الذكاء الاصطناعي الخاصة بها. قد ترغب شركة مالية -تعمل بموجب قوانين الإقراض العادل في الولايات المتحدة- في التحقق من نماذج الإقراض الخاصة بها بحثاً عن أوجه التحيز من أجل تخفيف المخاطر القانونية. وقد تقوم شركة توفر الرعاية الصحية عن بُعد -وتدرب أنظمتها على البيانات الطبية الحساسة- بإجراء عمليات تدقيق للخصوصية للتخفيف من مخاطر الإضرار بالسمعة.

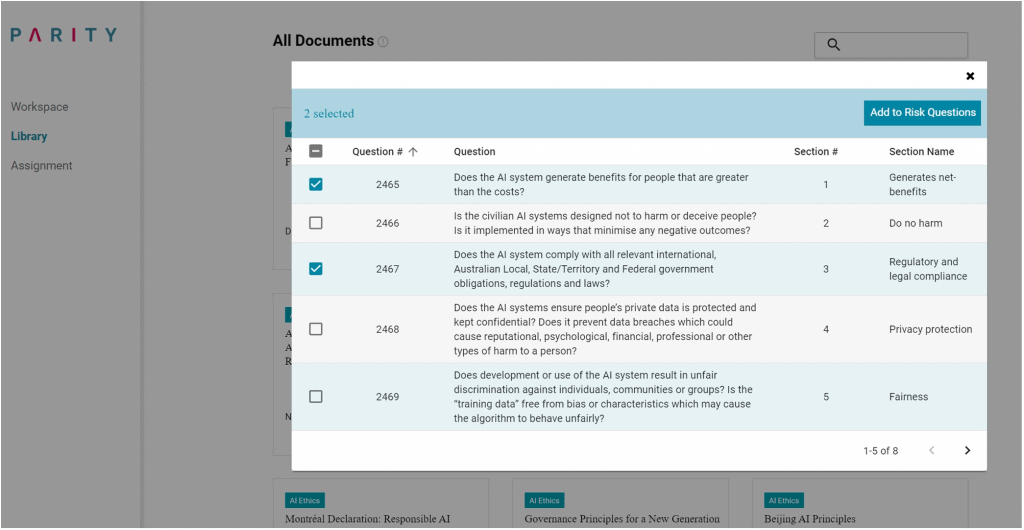

مصدر الصورة: باريتي

تساعد شركة باريتي على تنظيم هذه العملية؛ حيث تطلب المنصة أولاً من الشركة بناء تقييم داخلي للتأثير، وهو في جوهره عبارة عن مجموعة من أسئلة الاستطلاع المفتوحة حول كيفية عمل الشركة وأنظمتها الخاصة بالذكاء الاصطناعي. وتستطيع الشركة اختيار كتابة أسئلة مخصصة أو الاعتماد على أسئلة محددة من مجموعة باريتي التي تحتوي على أكثر من 1,000 سؤال مقتبس من إرشادات أخلاقيات الذكاء الاصطناعي والتشريعات ذات الصلة من جميع أنحاء العالم. ثم بمجرد بناء التقييم، يتم حثّ الموظفين في جميع أقسام الشركة على ملئه بناءً على وظيفتهم ومعرفتهم. تقوم المنصة بعد ذلك بتزويد إجابات النص الحر إلى نموذج معالجة لغة طبيعية وتعيد صياغتها وقولبتها مع التركيز على مجالات المخاطر الرئيسية للشركة. بعبارة أخرى، تعمل باريتي كوسيط جديد في توفير منصة تفاهم بين علماء البيانات والمحامين.

بعد ذلك، توصي المنصة بمجموعة موازية من إجراءات التخفيف من المخاطر. يمكن أن يشمل ذلك إنشاء لوحة معلومات لمراقبة دقة النموذج باستمرار، أو تنفيذ إجراءات توثيق جديدة لتتبع كيفية تدريب النموذج وتعديله في كل مرحلة من مراحل تطويره. كما تقدم مجموعة من المنصات والأدوات مفتوحة المصدر التي قد توفر بعض المساعدة مثل منصة آي بي إم المسماة إيه آي فيرنس (AI Fairness 360) لأغراض مراقبة التحيز أو جوجل مودل كاردس (Google’s Model Cards) لأغراض التوثيق.

تأمل شودري أنه إذا تمكنت الشركات من تقليل الوقت المستغرق في تدقيق نماذجها، فإنها ستصبح أكثر انضباطاً بشأن القيام بذلك بصورة منتظمة وأكثر تواتراً. وتأمل أن يؤدي ذلك بمرور الوقت إلى جعلها أكثر انفتاحاً للتفكير في جوانب أعمق من مجرد تخفيف المخاطر. وتقول: “في الحقيقة، يكمن هدفي الخفي وراء ذلك في جعل المزيد من الشركات تفكر في التأثير وليس مجرد المخاطر. فالمخاطر هي اللغة التي يفهمها الناس اليوم، وهي لغة قيمة للغاية، ولكن تخفيف المخاطر غالباً ما يكون رد فعل واستجابة لحدث ما. أما دراسة التأثير فهو أكثر استباقية، ويمثل في الواقع أفضل طريقة لتأطير ما يجب علينا القيام به”.

نظام بيئي لمسؤولية الذكاء الاصطناعي

بينما تركز باريتي على إدارة المخاطر، تركز شركة ناشئة أخرى، تسمى فيدلر (Fiddler)، على قابلية التفسير. بدأ الرئيس التنفيذي لفيدلر، كريشنا جايد، التفكير في الحاجة إلى توفير مزيد من الشفافية في كيفية اتخاذ نماذج الذكاء الاصطناعي للقرارات أثناء عمله مديراً هندسياً لفريق شريط منشورات فيسبوك. بعد الانتخابات الرئاسية الأميركية لعام 2016، بذلت الشركة جهوداً داخلية كبيرة لفهم أفضل لكيفية تصنيف خوارزمياتها للمحتوى. وطور فريق جايد أداة داخلية أصبحت فيما بعد أساساً لميزة “لماذا أرى هذا المنشور؟” على فيسبوك.

بعد ذلك بوقت قصير، أطلق جايد شركة فيدلر في أكتوبر 2018. تساعد هذه الشركة فرق علوم البيانات على تتبع تطور أداء نماذجهم، ثم تستخدم النتائج في إنشاء تقارير عالية المستوى وتقديمها للمدراء التنفيذيين. وإذا تدهورت دقة النموذج بمرور الوقت، أو أظهرت سلوكيات منحازة، فإن فيدلر تساعد في تصحيح سبب حدوث ذلك. يرى جايد أن مراقبة النماذج وتحسين قابلية تفسيرها تشكل الخطوات الأولى لاتخاذ قرارات مدروسة لتطوير ونشر الذكاء الاصطناعي.

هناك شركتان أخريان توفران منصات لمراقبة نماذج الذكاء الاصطناعي هما آرثر (Arthur)، التي تأسست عام 2019، وأوزان وتحيزات (Weights & Biases)، التي تأسست عام 2017. شأنها شأن فيدلر، تركز شركة آرثر على قابلية التفسير وتخفيف التحيز، بينما تتعقب شركة “أوزان وتحيزات” تجارب التعلم الآلي بهدف تحسين إمكانية إعادة إنتاج نتائج الأبحاث. لقد لاحظت الشركات الثلاثة تحولاً تدريجياً في محاور اهتمام الشركات: من الامتثال القانوني أو أداء النموذج إلى الأخلاقيات والمسؤولية.

تقول ليز أوسوليفان، نائبة رئيس شركة آرثر للذكاء الاصطناعي المسؤول والتي تشغل أيضاً منصب مدير التكنولوجيا في منظمة النشطاء المسماة (مشروع الإشراف على تكنولوجيا المراقبة): “كان الجزء الساخر مني قلقاً في البداية من أننا سنرى العملاء يأتون ويعتقدون أنه يمكنهم تلبية متطلبات أخلاقيات الذكاء الاصطناعي بمجرد ربط علامتهم التجارية بكيان آخر يتولى التعامل مع مسألة الذكاء الاصطناعي المسؤول”. ولكن العديد من عملاء شركة آرثر كانوا يأتون ساعين وراء ما هو أبعد من مجرد الحلول التقنية لبنى الحوكمة وأساليب التصميم الشامل لديهم. تقول أوسوليفان: “لقد كان من المثير جداً أن نشهد اهتماماً حقيقياً للعملاء بالقيام بالشيء الصحيح”.

كما تشعر كل من أوسوليفان وشودري بالحماسة لرؤية إطلاق المزيد من الشركات الناشئة المشابهة لشركتيهما. وتقول أوسوليفان: “لا توجد أداة واحدة أو شيء واحد تحتاج إلى القيام به حتى توفر متطلبات الذكاء الاصطناعي المسؤول”. توافق شودري على ذلك وتوضح أننا في حاجة إلى “نظام بيئي متكامل”.