من المتوقع للذكاء الاصطناعي أن يلعب دوراً أكبر بصورة ملموسة، وهو ما يثير قضية المساءلة. فإذا اعتمدنا على الآلات لاتخاذ قرارات تكتسي بأهمية متزايدة، فسنحتاج إلى توفر آليات للاستدراك والتعويض إذا تبيّن أن النتائج غير مقبولة أو يصعب فهمها.

ولكن جعل أنظمة الذكاء الاصطناعي تفسر قراراتها ليس بالأمر البسيط تماماً. إحدى المشاكل هي أن تقديم التفسيرات عملية مكلفة، فهو يتطلب موارد كبيرة سواء في تطوير نظام الذكاء الاصطناعي، أو في الطريقة التي يتم بها استجوابها من الناحية العملية.

ومن الشواغل الأخرى أن التفسيرات قد تكشف عن الأسرار التجارية عبر إجبار المطورين على نشر نشر الآليات الداخلية التي يعمل وفقها نظام الذكاء الاصطناعي. علاوة على ذلك، تتمثل إحدى مزايا هذه الأنظمة في قدرتها على فهم البيانات المعقدة بطرق يتعذر على البشر استخدامها. لذا فإن جعل تفسيراتها يسيرة الفهم على البشر قد يستدعي الانخفاض في أدائها.

إذاً، كيف يمكننا جعل الذكاء الاصطناعي مسؤولاً عن قراراته دون كبح إمكانات الابتكار؟

نحصل اليوم على إجابة من نوع من ما بفضل العمل الذي يقوم به كل من فينالي دوشي-فيليز، ماسون كورتز وآخرون في جامعة هارفارد في كامبريدج في ولاية ماساتشوستس.

هؤلاء الأشخاص يشكلون فريقاً من العلماء في مجالات الحاسوب، والإدراك والمعرفة، والقانون وقد تدارسوا معاً القضايا القانونية التي تثيرها أنظمة الذكاء الاصطناعي، وحددوا المشاكل الرئيسية، واقترحوا حلولاً ممكنة. تقول هذه المجموعة: "باجتماعنا نحن نعتبر خبراء في تقديم التفسيرات من الناحية القانونية، وابتكار أنظمة الذكاء الاصطناعي، والقدرات وأوجه القصور في المنطق البشري".

يبدأ الفريق بتعريف مصطلح "التفسير"، حيث يقولون: "عندما نتحدث عن تفسير قرار ما، فنحن نقصد بذلك عموماً الأسباب أو المبررات التي أفضت إلىى تلك النتيجة على وجه الخصوص، بدلاً من تقديم وصف عام لعملية صنع القرار".

هذا التمييز مهم للغاية، حيث تشير دوشي-فيليز وزملاؤها إلى إمكانية شرح الآلية التي يتخذ بها نظام الذكاء الاصطناعي القرارات على غرار إمكانية شرح كيفية عمل الجاذبية، أو كيفية تحضير الكعكة. ويتم ذلك من خلال شرح القواعد التي يتبعها النظام، دون الإشارة إلى أي جسم ساقط بعينه، أو أي كعكة بعينها.

هذا ما يخشاه الصناعيون الراغبون بالحفاظ على سرية الآليات التي تعمل وفقها أنظمة الذكاء الاصطناعي الخاصة بهم، وذلك لحماية مكاسبهم التجارية.

ولكن هذا النوع من الشفافية ليس ضرورياً في الكثير من الحالات. فتفسير سقوط جسم ما في أحد الحوادث الصناعية، على سبيل المثال، لا يتطلب عادةً تفسيراً لظاهرة الجاذبية. وإنما ما يستدعي تقديم التفسيرات عادةً هو الإجارة عن أسئلة مثل هذه: ما هي العوامل الرئيسية التي ساهمت في القرار؟ هل كان لتغيير عامل معين أن يغير من القرار؟ لماذا أدت حالتان متماثلتان إلى اتخاذ قرارين مختلفين؟

إن الإجابة عن هذه الأسئلة لا تتطلب بالضرورة شرحاً مفصلاً لآليات عمل نظام الذكاء الاصطناعي.

إذاً متى ينبغي تقديم التفسيرات؟ بشكل أساسي، عندما تتفوق الفائدة منها على الكلفة. تقول دوشي-فيليز وزملاؤها: "وجدنا أن هناك 3 شروط تميز الحالات التي يعتبر فيها المجتمع أن صانع القرار ملزمٌ – أخلاقياً، اجتماعياً، أو قانونياً – بتقديم تفسير له".

يقول الفريق إن القرار يجب أن يكون له تأثير على شخص آخر مختلف عن متخذ القرار. لا بد من إيلاء الأهمية لمعرفة ما إذا كان القرار قد اتخذ بطريقة خاطئة، ولا بد من وجود سبب ما للاعتقاد بأن ثمة خطأ ما قد حدث (أو سيحدث) في عملية اتخاذ القرار.

على سبيل المثال، قد يشتبه المراقبون بأن القرار قد تأثر بعامل ما عديم الصلة، كأن يرفض جرّاح ما إجراء العملية لأن القمر في طورٍ معين (لأنه بدر مثلاً). أو قد لا يثقون بالنظام إذا اتخذ القرار نفسه في مجموعتين مختلفتين تماماً من الظروف. في تلك الحالة، قد يتوقعون أنه فشل في مراعاة أحد العوامل الهامة.

ينشأ شاغل آخر إزاء القرارات التي يبدو أنها تصب في مصلحة فئة معينة بشكل غير عادل، كما يحدث عندما يتخذ مدراء الشركات قرارات تصب في مصلحتهم على حساب حملة الأسهم لديهم.

بعبارة أخرى، لا بد من وجود سبب وجيه للاعتقاد بأن القرار غير مناسب قبل المطالبة بتقديم تفسير له. ولكن يحتمل وجود أسباب أخرى أيضاً لتقديم التفسيرات، كمحاولة زيادة الثقة المتبادلة مع المستهلكين.

لذا فإن دوشي-فيليز وزملاؤها ينظرون في الحالات القانونية الملموسة التي تتطلب تقديم التفسيرات. وهم يشيرون إلى أن العقول المنطقية يمكن لها في الواقع أن تختلف بشأن ما إذا كانت المطالبة بتقديم التفسيرات أمراً مبرراً من الناحية الأخلاقية، أو ملائماً من الناحية الاجتماعية.

يقول الفريق: "من ناحية أخرى فإن القوانين منظمة ومدونة، وفي حين يمكن للمرء أن يجادل بشأن صحة قانون ما، فإننا نعرف على الأقل ما هو نص القانون".

بموجب القانون الأميركي، هناك حاجة لتقديم التفسيرات في مجموعة واسعة من الحالات ومستويات مختلفة من التفصيل. على سبيل المثال، هناك حاجة إلى تقديم التفسيرات في حالات المسؤولية القانونية المطلقة (كجرائم القتل)، أو الطلاق، أو التمييز في المعاملة، لاتخاذ القرارات الإدارية، وأمام القضاة وهيئات المحلفين. لكن هناك تفاوت كبير في مستوى التفصيل.

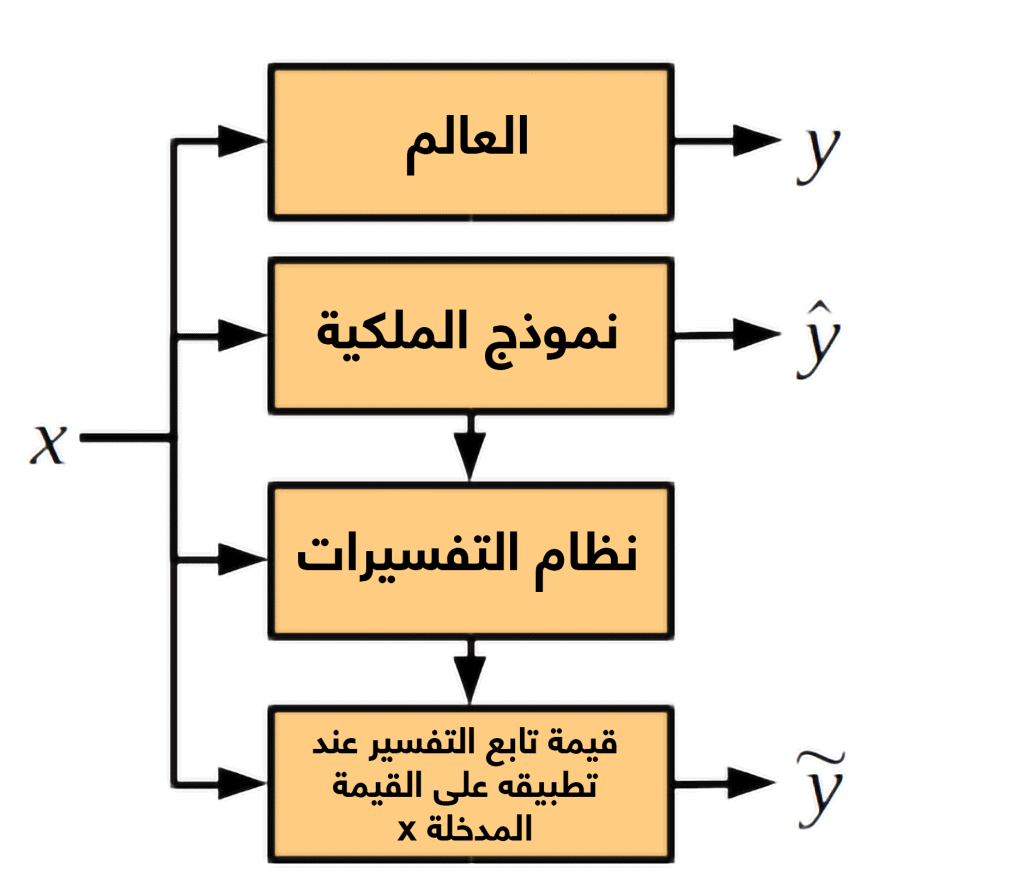

كل ذلك له آثار هامة على أنظمة الذكاء الاصطناعي. حيث خلصت دوشي-فيليز وزملاؤها إلى أن التفسيرات المجدية من الناحية القانونية تعدّ خياراً ممكناً لأنظمة الذكاء الاصطناعي. وذلك لأن تفسير قرار ما يمكن أن يتم بمعزل عن وصف آليات عمله الداخلية. والأكثر من ذلك، يقول الفريق إن نظام تقديم التفسيرات يجب اعتباره مستقلاً عن نظام الذكاء الاصطناعي.

هذه نتيجة مهمة، لكن هذا لا يعني أنه سيكون من السهل دائماً توليد تفسيرات مقنعة. على سبيل المثال، كيف يمكننا أن نستوضح على سبيل المثال، ما إذا كان النظام الأمني الذي يستخدم صوراً للوجوه كدخل له لا يميز بينها على أساس الجنس؟ يقول الفريق إنه لا يمكن التحقق من ذلك إلا باستخدام صورة بديلة لأحد الوجوه، بحيث تكون مشابهة لها في كل شيء باستثناء الجنس.

ولكن تقديم التفسيرات بشأن القرارات التي تتخذها نظم الذكاء الاصطناعي يعد أمراً ممكناً بشكل عام، وهذا ما يقود الفريق إلى نتيجة واضحة. يقول الفريق: "ما نوصي به في الوقت الحاضر، هو أن أنظمة الذكاء الاصطناعي يمكنها ويتوجب عليها أن تخضع إلى معيار مماثل للتفسيرات كما هو الحال بالنسبة للبشر اليوم".

ولكن استخدامنا وفهمنا للذكاء الاصطناعي من المرجح أنهما سيتغيران بطرق لم نفهمها بعد (وربما لن نفهمها أبداً). لهذا السبب، يتوجب علينا إعادة النظر في هذه المقاربة. تقول دوشي-فيليز وزملاؤها أخيراً: "لعلنا نأمل في المستقبل أن نُخضع الذكاء الاصطناعي لمعيار مختلف".

لا شك أننا نتفق معهم!

مرجع: arxiv.org/abs/1711.01134: مساءلة الذكاء الاصطناعي بموجب القانون: دور التفسيرات