على الرغم من وجود الكثير من أنظمة الذكاء الاصطناعي التي يبدو ظاهرياً أنها تفهم اللغة، والتي تحقق نتائج أفضل من البشر في مجموعة معتادة من اختبارات الاستيعاب، فإنها لا تلاحظ اختلاط كلمات الجمل، ما يبين أنها لا تستوعب اللغة بشكل فعلي على الإطلاق. تكمن المشكلة في طريقة تدريب أنظمة معالجة اللغة الطبيعية، كما أنها تشير أيضاً إلى طريقة لتحسينها.

تمكن باحثون في جامعة أوبورن في ألاباما ومركز أبحاث أدوبي من اكتشاف الخطأ عندما حاولوا دفع نظام لمعالجة اللغة الطبيعية إلى توليد تفسيرات لسلوكه، مثل سبب ادعائه لوجود نفس المعنى لجمل مختلفة. وعندما اختبر الباحثون هذه الطريقة، أدركوا أن تبديل أماكن الكلمات في الجملة لم يؤدِّ إلى أي تغيير في الشروحات. يقول آن نجويين من جامعة أوبورن، والذي قاد البحث: “إنها مشكلة عامة بالنسبة لجميع نماذج معالجة اللغة الطبيعية”.

قام الفريق بدراسة عدد من أحدث أنظمة معالجة اللغة الطبيعية المبنية على بيرت، وهو النموذج اللغوي الذي طورته جوجل، والذي يُعتبر أساساً للكثير من الأنظمة الحديثة، بما فيها جي بي تي 3. تستطيع جميع هذه الأنظمة تحقيق نتائج أفضل من البشر في اختبار جلو GLU (اختصاراً لعبارة تقييم الاستيعاب العام للغة)، وهو عبارة عن مجموعة معيارية من المهام المصممة لاختبار القدرة على استيعاب اللغة، مثل اكتشاف الصياغات الجديدة وتحديد الطابع السلبي أو الإيجابي للمشاعر التي تعبر عنها الجملة أو التفكير المنطقي الشفهي.

رجل يعض كلباً

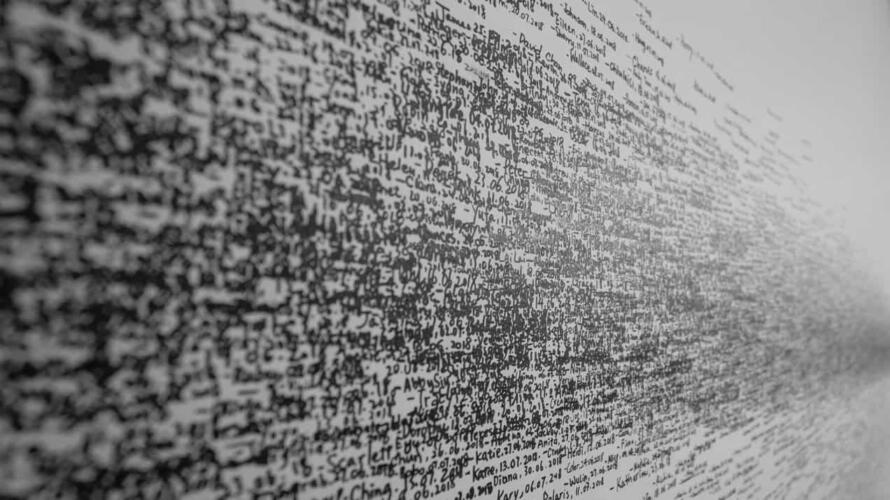

وجد الباحثون أن هذه الأنظمة لم تستطع تمييز حالة خلط الكلمات ضمن الجمل، حتى لو أدى الترتيب الجديد إلى تغيير المعنى. وعلى سبيل المثال، نجحت هذه الأنظمة في اكتشاف وجود صياغة مختلفة لنفس المعنى في الجملتين “هل يتسبب الماريجوانا بالسرطان؟” و”كيف يمكن لتدخين الماريجوانا أن يتسبب لك بسرطان الرئة؟” غير أنها كانت حتى أكثر حسماً في اعتقادها بأن الجملتين “لك لتدخين السرطان كيف الماريجوانا الرئة يمكن أن يتسبب؟” و”الرئة يمكن أن يتسبب الماريجوانا لتدخين كيف لك بالسرطان؟” تحملان نفس المعنى أيضاً. كما قررت الأنظمة بأن الجمل التي تحمل معاني متعاكسة، مثل “هل يتسبب الماريجوانا بالسرطان؟” و”هل يتسبب السرطان بالماريجوانا؟”، تمثل نفس السؤال.

وفي الواقع، فإن المهمة الوحيدة التي تأثرت بترتيب الكلمات هي التحقق من سلامة التركيب القواعدي للجملة. أما فيما عدا ذلك، فإن نسبة 75% إلى 90% من إجابات الأنظمة لم تتغير عند تغيير ترتيب الكلمات.

ما الذي يحدث بالضبط؟

يبدو أن الأنظمة تركز على بضع كلمات مفتاحية في الكلمة، بغض النظر عن ترتيب ورودها. إنها لا تفهم اللغة مثلنا، كما أن جلو -وهو معيار رائج للغاية- لا يقيس الاستخدام الفعلي للغة؛ ففي حالات كثيرة، يتم تدريب النموذج على مهمة لا ترغمه على الاهتمام بترتيب الكلمات أو بالسياق بشكل عام. ويمكن باختصار أن نقول إن جلو يعلم نماذج معالجة اللغة الطبيعية تجاوز مراحل العمل وحسب.

وعلى الرغم من أن الكثير من الباحثين بدؤوا يستخدمون مجموعة أكثر صعوبة من الاختبارات تحمل اسم سوبرجلو، فإن نجويين يشك في أنها ستعاني من مشاكل مماثلة.

اكتشف يوشوا بينجيو وزملاؤه هذه المشكلة أيضاً، فقد وجدوا أن تغيير ترتيب الكلمات في الحوار لم يغير استجابات بوتات الدردشة في بعض الأحيان. كما اكتشف فريق من قسم أبحاث الذكاء الاصطناعي في فيسبوك أمثلة على حدوث هذا في اللغة الصينية. وقد أثبت فريق نجويين أن المشكلة منتشرة على نطاق واسع.

هل هذا الأمر مهم فعلاً؟ يعتمد هذا على التطبيق؛ فمن جهة، من المفيد وجود نظام ذكاء اصطناعي قادر على تمييز الخطأ الطباعي أو النطق بكلمات مشوشة، كما يفعل أي شخص. ولكن، وبشكل عام، فإن ترتيب الكلمات أمر حساس وهام لدى محاولة تفسير معاني الجمل.

هذه يمكن كيف المشكلة أن نعالج؟

من المريح معرفة أن معالجة هذه المشكلة قد لا تكون بهذه الصعوبة؛ فقد وجد الباحثون أن إرغام النموذج على التركيز على ترتيب الكلمات -وذلك بتدريبه على مهام تأخذ الترتيب بعين الاعتبار (مثل كشف الأخطاء القواعدية)- يحسن من أداء النموذج في المهام الأخرى. وهو ما يشير إلى أن تعديل مهام التدريب سيحسن من النماذج بشكل عام.

تمثل نتائج نجويين مثالاً آخر على كون النماذج أقل فعالية بكثير من التصور الشائع لدى العامة في أغلب الأحيان. ويعتقد أنها تبرز صعوبة تصميم أنظمة ذكاء اصطناعي قادرة على الاستيعاب والتفكير المنطقي مثل البشر. ويقول: “ليس لدينا أدنى فكرة”.