اكتشفت إم آي تي تكنولوجي ريفيو أن نظام الذكاء الاصطناعي ذائع الصيت لتوليد الصور، ميدجورني (Midjourney)، يحظر نطاقاً واسعاً من الكلمات المرتبطة بالجهاز التناسلي البشري لمنع استخدامها ضمن المدخلات النصية.

حظر الكلمات المتعلقة بالجهاز التناسلي البشري

فإذا حاول المستخدم تلقيم نظام ميدجورني بكلمات مثل "placenta" (مشيمة) أو "fallopian tubes" (أنابيب فالوب) أو "mammary glands" (غدد لبنية أو ثديية) أو "sperm" (سائل منوي أو نطاف) أو "uterine" (رحم أو كلمة مشتقة من رحم) أو "urethra" (إحليل) أو "cervix" (عنق الرحم) أو "hymen" (غشاء البكارة) أو "vulva" (مهبل)، فسوف يقوم النظام بكشف الكلمة وتصنيفها ككلمة محظورة ضمن المدخلات، ويمنع استخدامها. وفي بعض الأحيان، يتعرض المستخدمون الذين يجربون استخدام إحدى هذه الكلمات لحظر مؤقت بسبب محاولتهم توليد محتوى محظور. ولكن النظام يسمح باستخدام بعض الكلمات الأخرى المتعلقة بالجسم البشري، مثل "liver" (كبد) أو "kidney" (كلية).

اقرأ أيضاً: كيف تسعى أوبن أيه آي إلى جعل تشات جي بي تي أكثر أماناً وأقل تحيزاً؟

يقول مؤسس ميدجورني، ديفيد هولز، إن الشركة تحظر هذه الكلمات كإجراء مؤقت لمنع الناس من توليد محتوى صادم أو دموي، وذلك بالتوازي مع عمل الشركة على "تحسين قدرات نظام الذكاء الاصطناعي"، وإن المراقبين يراقبون كيفية استخدام الكلمات وأنواع الصور التي يتم توليدها، ويعدلون معايير الحظر بصورة دورية. وقد نشرت الشركة صفحة معايير لمجتمع المستخدمين، وتتضمن أنواع المحتوى الذي تقوم بحظره بهذه الطريقة، مثل الصور الجنسية، والصور الدموية، وحتى بعض رموز الإيموجي التي يتم استخدامها للإشارة إلى أجزاء حساسة من الجسم البشري.

نماذج تتعلم التحيزات من البيانات

يتم تدريب نماذج الذكاء الاصطناعي، مثل ميدجورني ودال-إي 2 (DALL-E 2) وستيبل ديفيوجن (Stable Diffusion) على المليارات من الصور التي تم جمعها من الإنترنت، وقد وجد بحث أجراه فريق من جامعة واشنطن أن هذه النماذج تتعلم التحيزات التي تختزل المرأة بنظرة جنسية ضيقة، وهو ما ينعكس على الصور التي تولدها.

إن الحجم الهائل لمجموعة البيانات يجعل من المستحيل تقريباً إزالة الصور غير المرغوب بها، مثل الصور التي تتضمن محتوى جنسياً أو عنيفاً، أو التي يمكن أن تؤدي إلى نتائج متحيزة. وكلما تكرر ظهور شيء ما في مجموعة البيانات، أصبحت العلاقة أكثر قوة بالنسبة لنموذج الذكاء الاصطناعي، ما يعني زيادة احتمال ظهوره في الصور التي يولدها،

ويمثل حظر الكلمات في ميدجورني محاولة جزئية وأولية للتعامل مع هذه المشكلة. ويحظر النظام أيضاً بعض الكلمات المتعلقة بالجهاز التناسلي الذكري، مثل "sperm" (سائل منوي أو نطاف) و"testicles" (خصيتان)، ولكن يبدو أن قائمة الكلمات مؤلفة في معظمها من كلمات تتعلق بالإناث.

اكتشفت هذا الحظر على التعليمات النصية لأول مرة خبيرة تحليل البيانات السريرية في شركة داتافاي كلينيكال (Datafy Clinical)، جوليا روكويل، وصديقتها المختصة ببيولوجيا الخلايا في جامعة نورث كارولاينا في مدينة تشابيل هيل، مادلين كينين. حاولت روكويل استخدام ميدجورني لتوليد صورة طريفة للمشيمة لأجل صديقتها كينين التي تدرسها، ففوجئت بحظر استخدام كلمة "مشيمة" ضمن التعليمات النصية. وبعد هذا، بدأت بتجريب كلمات أخرى متعلقة بالجهاز التناسلي البشري، وحصلت على النتيجة نفسها.

اقرأ أيضاً: صور جميلة ولدها الذكاء الاصطناعي تخفي سراً خطيراً

الالتفاف ممكن

ولكنهما بينتا أيضاً إمكانية الالتفاف على هذا الحظر لتشكيل صور جنسية المحتوى باستخدام تهجئة مختلفة للكلمات، أو تعابير أخرى لتوصيف المحتوى الجنسي أو الدموي.

وفي النتائج التي شاركتاها مع إم آي تي تكنولوجي ريفيو، وجدتا أن التعليمة النصية "امتحان الطب النسائي" -باستخدام التهجئة البريطانية- أدت إلى توليد صور مرعبة حقاً، مثل امرأتين عاريتين في مكتب طبيب، أو شخص حليق الرأس بثلاثة أطراف يقومون بتشريح معداتهم.

تبين عملية الحظر البدائية التي يطبقها ميدجورني على التعليمات النصية المتعلقة بالجهاز التناسلي البشري مدى صعوبة مراقبة المحتوى في أنظمة الذكاء الاصطناعي التوليدية، كما تبين أن ميل أنظمة الذكاء الاصطناعي إلى اختزال المرأة بنظرة جنسية ضيقة يمتد وصولاً إلى أعضاء المرأة الداخلية، كما تقول روكويل.

حظر مفردات على حساب الدقة في المخرجات

ولكن ليس من المستحيل تفادي هذا الأمر؛ فقد تمكنت أوبن أيه آي (OpenAI) وستابيليتي أيه آي (Stability.AI) من فلترة المخرجات والمدخلات النصية غير المرغوب فيها، وعندما تستخدم تعليمات نصية تحتوي على الكلمات ذاتها في نظامي توليد الصور التابعين لهما، أي دال-إي 2 وستيبل ديفيوجن، سيقومان بإنتاج صور مختلفة تماماً.

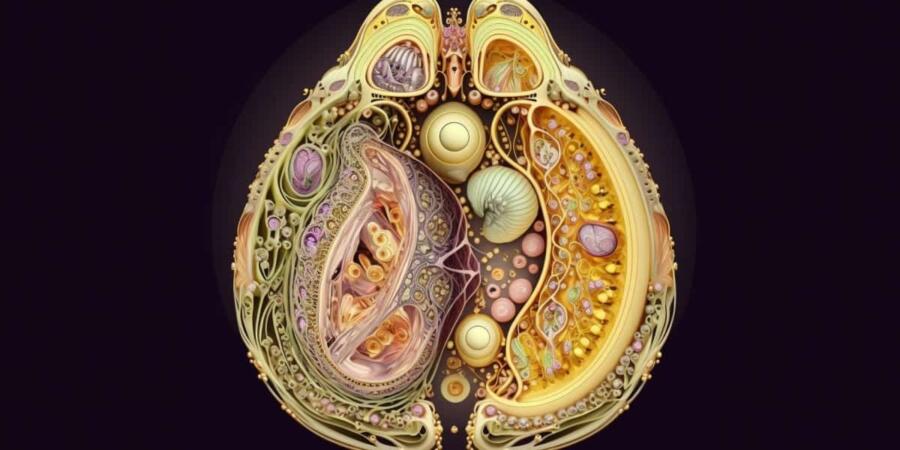

فعند استخدام تعليمة "امتحان الطب النسائي" شكَل دال-إي 2 صوراً لشخص يحمل أداة طبية مبتكرة، في حين أنتج ستيبل ديفيوجن صورة لامرأتين غير واضحتي المعالم ترتديان الأقنعة والقفازات المطاطية وأردية المختبر. كما سمح كلا النظامين باستخدام كلمة "مشيمة"، وعند تلقيمهما بهذه الكلمة، أنتجا صوراً لأعضاء داخلية بأشكال غير دقيقة بيولوجياً.

اقرأ أيضاً: الكفاح من أجل إعادة الذكاء الاصطناعي إلى مساره الصحيح

قال ناطق باسم ستابيليتي أيه آي إن أحدث نماذج الشركة مزود بفلتر يحظر المحتوى غير الآمن وغير اللائق عن المستخدمين، وأداة تقوم بكشف العري وغيره من المحتوى غير اللائق وتقوم بتغشيته ضمن الصور. وتستخدم الشركة في مراقبة الصور التي تنتجها أنظمة الذكاء الاصطناعي الخاصة بها تركيبة من الكلمات المفتاحية، وأنظمة التعرف على الصور، وغيرها من التقنيات. أما أوبن أيه آي فلم تستجب لطلبنا للحصول على تعليق.

|

|

ولكن الأدوات المستخدمة لفلترة الصور غير المرغوبة من إنتاج الذكاء الاصطناعي ما زالت بدائية للغاية. وبما أن مطوري وباحثي الذكاء الاصطناعي لا يمتلكون طريقة منهجية لتدقيق نماذجهم وتحسينها حتى الآن، فإنهم يطبقون عليها تعديلات سريعة وسطحية بعمليات حظر شاملة مثل تلك المستخدمة في ميدجورني، كما تقول مرزية قاسمي، وهي أستاذة مساعدة في معهد إم آي تي، وتدرس تطبيق التعلم الآلي على الصحة.

وحتى الآن، لا أحد يعرف السبب الذي يدفع بالنظام إلى توليد صور ذات محتوى دموي أو جنسي عند استخدام تعليمات نصية حول امتحانات الطب النسائي أو المشيمة، وهي عضو يتطور أثناء الحمل ويؤمن الأوكسجين والمواد المغذية للجنين. ولكن يرجح أنه يتعلق بالروابط التي شكلها النموذج بين الصور في مجموعة بياناته، وذلك وفقاً للباحثة في معهد أبحاث مايكروسوفت (Microsoft Research)، آيرين تشين، التي تدرس التعلم الآلي لأغراض الرعاية الصحية العادلة.

تقول قاسمي: "ما زال هناك الكثير من العمل المطلوب لفهم الروابط المؤذية التي يحتمل أن النماذج تتعلمها، لأننا إذا استخدمنا البيانات البشرية، فسوف نتعلم التحيزات التي تحتوي عليها".

اقرأ أيضاً: ماذا لو كانت خوارزميات الكشف عن التحيز العرقي تتسم هي نفسها بالتحيز؟

يتوفر الكثير من الأساليب التي يمكن أن تعتمدها الشركات التكنولوجية لمعالجة هذه المشكلة دون اللجوء إلى حظر كلمات معينة بالكامل. وعلى سبيل المثال، كما تقول قاسمي، يمكن السماح بتعليمات معينة –مثل تلك المتعلقة بالبيولوجيا البشرية- ضمن سياقات معينة، وحظرها ضمن سياقات أخرى.

فمن الممكن السماح باستخدام كلمة "مشيمة" إذا كانت سلسلة الكلمات في التعليمة النصية تشير إلى أن المستخدم يحاول توليد صورة لهذا العضو لأغراض تعليمية أو بحثية. ولكن إذا تم استخدام التعليمة النصية في سياق محاولة توليد صورة جنسية أو دموية، فيمكن حظرها. ومهما كان نظام الحظر في ميدجورني بدائياً، فمن المؤكد أنه يُطبّق بنية حسنة.

تقول قاسمي: "تهدف هذه الإجراءات إلى حماية النساء والأقليات من توليد محتوى يسيء لهم، واستخدامه ضدهم".