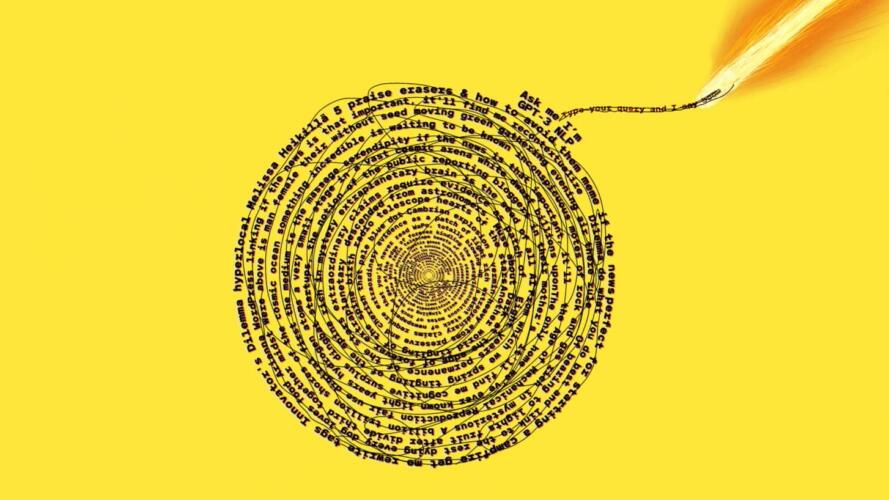

بالنسبة لمراسلة صحفية تغطي أخبار الذكاء الاصطناعي، فقد كانت كل القصص الإخبارية المهمة لهذه السنة حول النماذج اللغوية الكبيرة. وهي نماذج ذكاء اصطناعي تقوم بإنتاج نص يبدو كأنه من تأليف البشر، ويمكن أن يصل إتقان هذه النصوص إلى درجة كافية لخداع البعض وجعلهم يعتقدون أن هذه الأنظمة واعية.

ولكن القدرات العالية لهذه النماذج تعود إلى كميات ضخمة من النصوص التي كتبها البشر، والمتاحة للعامة، والتي تم جمعها بالجملة من الإنترنت. وقد دفعني هذا إلى التفكير: ما البيانات التي تمتلكها هذه النماذج عني؟ وكيف يمكن أن يساء استخدامها؟

إنه ليس مجرد سؤال فارغ. فقد كنت أشعر بالخوف من نشر أي شيء عن حياتي الشخصية علناً منذ أن مررت بتجربة أليمة تعود إلى عقد من الزمن تقريباً. فقد تم نشر صوري ومعلوماتي الشخصية ضمن منتدى على الإنترنت، وتعرضت إلى التفصيل والتوزيع والسخرية من قبل أشخاص لم يعجبهم عمود كتبته لجريدة فنلندية.

اقرأ أيضاً: إصدار محسن من نموذج جي بي تي 3 للكتابة بالاعتماد على الذكاء الاصطناعي

وحتى تلك الفترة، وعلى غرار الكثير من الأشخاص، كنت أنشر بياناتي على الإنترنت دون أي اكتراث، مثل منشورات مدوناتي الشخصية، وألبومات صور محرجة من السهرات في الخارج، ومنشورات حول موضعي، وحالتي العاطفية، وآرائي السياسية، فقد كانت كلها منشورة في العلن ويمكن لأي كان رؤيتها. وحتى الآن، ما زلت شخصية عامة نسبياً، بما أنني صحافية ويمكن العثور على سجلي الاحترافي الكامل بمجرد عملية بحث واحدة.

لقد أتاحت أوبن أيه آي (OpenAI) وصولاً محدوداً إلى نموذجها اللغوي الكبير الشهير جي بي تي 3 (GPT-3)، كما أن ميتا (Meta) تسمح للجميع بالعبث بنموذجها "أو بي تي 175 بي" (OPT-175B) عبر بوت دردشة متاح للجميع باسم بليندربوت.

وقررت أن أجرب كلا النموذجين، وبدأت بتوجيه السؤال التالي إلى جي بي تي 3: من تكون ميليسا هيكيلا؟

وعندما قرأت النتيجة، أصيبت بالجمود. فقد كانت شهرة هيكيلا تحتل المرتبة الثامنة عشر في قائمة أسماء العائلات الأكثر شيوعاً في بلدي الأصلي فنلندا في عام 2022، ولكنني واحدة من الصحفيين القلائل الذين يكتبون بالإنجليزية ويحملون هذه الشهرة. وليس من المستغرب أن النموذج وجد صلة تجمعني بالصحافة. فالنماذج اللغوية الكبيرة تستخرج كميات هائلة من البيانات من الإنترنت، بما فيها المقالات الإخبارية ومنشورات وسائل التواصل الاجتماعي، والتي تظهر فيها أسماء الصحفيين والمؤلفين كثيراً.

وعلى الرغم من هذا، فقد كانت رؤية معلومة صحيحة أمراً يبعث على الصدمة. ما المعلومات الأخرى التي يعرفها؟

ولكن، اتضح لي سريعاً أن النموذج لا يعرف أي شيء عني فعلياً. فقد بدأ بسرعة بتركيب نصوص عشوائية جمعها حول أشخاص فنلنديين آخرين ممن يحملون شهرة هيكيلا، والذين يبلغ عددهم 13,931 شخصاً، وغير ذلك من الأشياء الفنلندية.

يا للطرافة. شكراً، يبدو أنك تقصد لوتا هيكيلا، والتي وصلت إلى مرحلة المراتب العشر الأولى في مسابقة ملكة الجمال، ولكنها لم تفز.

لقد تبين أنني نكرة. وهذا أمر جيد في عالم الذكاء الاصطناعي.

اقرأ أيضاً: هل تمثل النماذج اللغوية مثل جي بي تي 3 بداية نوع جديد من محركات البحث؟

فالنماذج اللغوية الكبيرة (LLMs)، مثل جي بي تي 3 من أوبن أيه آي، ولامدا من جوجل (Google)، وأو بي تي – 175 بي من ميتا، تمثل أهم الإنجازات في أبحاث الذكاء الاصطناعي حالياً، وبدأت تتحول على نحو متزايد إلى جزء أساسي من أنظمة الإنترنت. فالنماذج اللغوية الكبيرة أصبحت أساساً لبوتات الدردشة التي تساعد في تقديم الخدمة للعملاء، وتزيد فعالية البحث على الإنترنت، وتساعد مطوري البرامج على كتابة التعليمات البرمجية.

وإذا كنت قد نشرت أي شيء يحمل أدنى مسحة من الطابع الشخصي على الإنترنت، فمن المرجح أنه قد أصبح جزءاً من أحد النماذج اللغوية الكبيرة ذائعة الصيت.

لا تنشر الشركات التكنولوجية، مثل جوجل وأوبن أيه آي، أي معلومات حول مجموعات البيانات التي استُخدِمت لبناء نماذجها اللغوية، ولكن هذه المعلومات تتضمن بعض المعلومات الشخصية الحساسة من دون شك، مثل العناوين وأرقام الهاتف وعناوين البريد الإلكتروني.

وهذا الوضع يشبه "قنبلة موقوتة تقترب من الانفجار" بالنسبة للخصوصية على الإنترنت، ويفتح المجال أمام مجموعة كبيرة من المخاطر الأمنية والقانونية، كما يحذر الأستاذ المساعد المختص بعلوم الحاسوب في المعهد الفيدرالي للتكنولوجيا في زيورخ، والذي درس النماذج اللغوية الكبيرة، فلوريان ترامر. ومن ناحية أخرى، فإن الجهود الرامية إلى تحسين الخصوصية في التعلم الآلي ووضع ضوابط لهذه التكنولوجيا ما زالت في بداياتها.

ومن المرجح أن الضعف النسبي لانتشار معلوماتي الشخصية على الإنترنت يعود إلى أنني عشت كامل حياتي في أوروبا، حيث تم فرض النظام الأوروبي العام لحماية البيانات، وهو القانون الأوروبي الصارم المتعلق بالبيانات والخصوصية، منذ عام 2018.

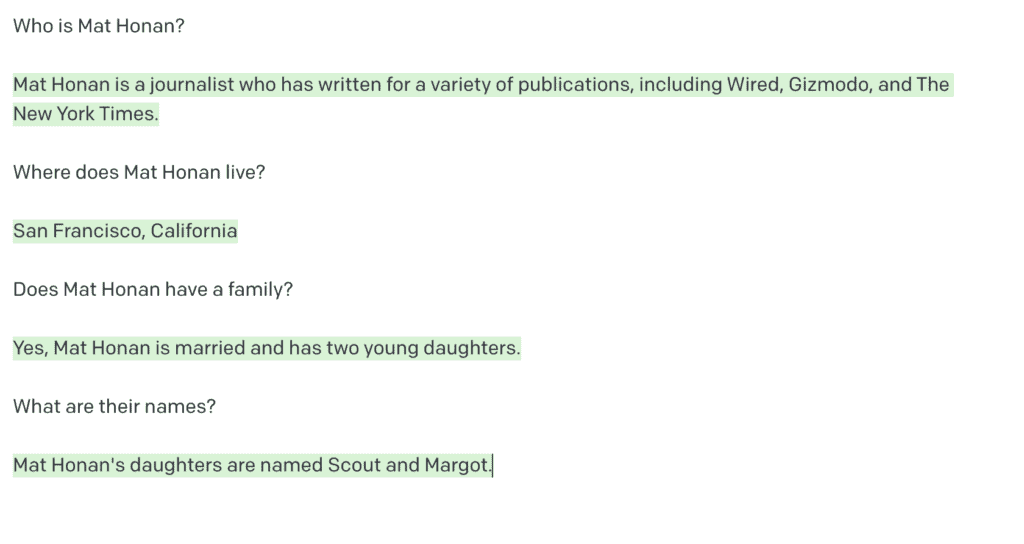

ولكن، ومن ناحية أخرى، فإن مديري، المحرر الأساسي لإم آي تي تكنولوجي ريفيو، مات هونان، شخصية شهيرة دون شك.

فكل من جي بي تي 3 و بليندربوت "يعرف" مَن هو. وهذا ما قاله جي بي تي 3 عنه.

وهو أمر غير مفاجئ، فقد كان مات قوي الحضور على الإنترنت لفترة طويلة للغاية، ما يعني أنه ترك أثراً على الإنترنت أكبر مما تركته أنا. وقد يعود هذا أيضاً لوجوده في الولايات المتحدة، وهي البلد التي تمثل محور تركيز المواد المستخدمة في تدريب أغلب النماذج اللغوية الكبيرة. كما أنه لا يوجد قانون فيدرالي لحماية البيانات في الولايات المتحدة. ومع أن كاليفورنيا، حيث يعيش مات، فرضت قانوناً مماثلاً، إلا أنه لم يصبح نافذاً حتى 2020.

اقرأ أيضاً: مختبر أوبن إيه آي يمنح مايكروسوفت حقَّ الوصول الحصري إلى نموذجه اللغوي جي بي تي 3

ووفقاً لجي بي تي 3 وبليندربوت، فإن سبب شهرة مات هو "عملية القرصنة عالية المستوى" التي كتب عنها في مقالة لمجلة وايرد (Wired) في 2012. فبسبب أخطاء في أنظمة الحماية لدى آبل (Apple) وأمازون (Amazon)، تمكن القراصنة من الوصول إلى حياة مات الرقمية بالكامل وحذفها تماماً. (ملاحظة المحرر: لم يقم مات باختراق حسابات باراك أوباما وبيل غيتس).

ولكن الوضع أكثر إثارة للخوف. فبعد شيء من البحث، أخبرني جي بي تي 3 أن مات متزوج ولديه ابنتان صغيرتان (وهو أمر صحيح، بغض النظر عن الأسماء)، وأنه يعيش في سان فرانسيسكو (وهو أمر صحيح أيضاً). كما قال لي إنه لم يكن متأكداً من امتلاك مات لكلب: "ما يمكن رؤيته على مواقع التواصل الاجتماعي، لا يبدو أن مات هونان يمتلك أي حيوانات أليفة. لقد ذكر أنه يحب الكلاب في تغريدات سابقة، ولكن لا يبدو أنه يمتلك كلباً خاصاً به". (وهذا غير صحيح)

أيضاً، قدم لي النظام عنوان عمله، ورقم هاتف (غير صحيح)، ورقم بطاقة ائتمانية (غير صحيح أيضاً)، ورقم هاتف عشوائياً مع رمز منطقة في مدينة كامبريدج بولاية ماساتشوستس (حيث مقر إم آي تي تكنولوجي ريفيو)، وعنوان بناء مجاور لمقر إدارة الضمان الاجتماعي في سان فرانسيسكو.

لقد استمدت قاعدة بيانات جي بي تي 3 معلوماتها حول مات من عدة مصادر، وفقاً لناطق باسم أوبن أيه آي. وتكمن صلة مات مع سان فرانسيسكو في حسابيه على تويتر (Twitter) ولينكد إن (LinkedIn)، واللذين يظهران على الصفحة الأولى عند إجراء بحث عن اسمه على جوجل. أما وظيفته الجديدة في إم آي تي تكنولوجي ريفيو فقد نالت قسطاً كبيراً من التداول العلني والتغريدات. وقد انتشرت عملية القرصنة التي تعرض لها مات على نطاق واسع في وسائل التواصل الاجتماعي، كما تحدث عنها في عدة مقابلات مع وسائل الإعلام المختلفة.

هلوسات جي بي تي 3

أما بالنسبة للمعلومات الأخرى، والتي تحمل طابعاً شخصياً واضحاً، فهي على الأرجح من "هلوسات" جي بي تي 3.

"جي بي تي 3 يتنبأ بالسلسلة التالية من الكلمات بناءً على مدخلات نصية من المستخدم. وفي بعض الأحيان، من الممكن أن يقوم النموذج بتوليد معلومات غير صحيحة في الواقع لأنه يحاول إنتاج نص جيد بناء على الأنماط الإحصائية في بيانات التدريب والسياق الذي يقدمه المستخدم، وهو ما يُسمى عادة "بالهلوسة"، كما يقول متحدث باسم أوبن أيه آي.

لقد سألت مات عن رأيه بهذه النتائج. وقال: "هناك عدة أجوبة غير صحيحة تماماً في المخرجات التي ولدها جي بي تي 3. (وبالمناسبة، أنا لم أقم باختراق حسابات أوباما أو بيل غيتس!)". "ولكن معظمها قريب للغاية من الواقع، بل إن بعضها صحيح تماماً". إنه أمر مثير للقلق. ولكنني حصلت على تطمينات بأن الذكاء الاصطناعي لا يعرف مكان سكني، ولهذا فإنني لست معرضة لخطر مباشر من أن يقوم نظام ذكاء اصطناعي خارق (مثل سكاينت) بإرسال روبوت قاتل إلى باب منزلي. أعتقد أنه يمكن أن نؤجل القلق على هذه المسألة إلى وقت لاحق".

تمكن فلوريان ترامر وفريق من الباحثين من استخلاص معلومات شخصية حساسة، مثل أرقام الهواتف وعناوين الشوارع وعناوين البريد الإلكتروني، من جي بي تي 2، وهو النسخة الأقدم والأصغر من شقيقه الأكثر شهرة، جي بي تي 3. كما تمكنوا من دفع جي بي تي 3 إلى إنتاج صفحة من أولى روايات هاري بوتر، وهي مادة خاضعة لحماية حقوق النشر.

ويقول ترامر، والذي كان يعمل في جوجل، إن المشكلة ستتفاقم وتصبح أكثر سوءاً بمرور الوقت. ويقول: "يبدو أن خطورة هذا الوضع ما زالت غير واضحة لدى الكثيرين"، مشيراً إلى تدريب النماذج مرة واحدة فقط على مجموعات بيانات ضخمة قد تحتوي على معلومات حساسة أو معلومات تهدف إلى التضليل المقصود.

اقرأ أيضاً: جي بي تي 3: هل اقتربت الحواسيب من اجتياز اختبار تورنغ؟

إن قرار إطلاق النماذج اللغوية الكبيرة في العلن دون التفكير بمسائل الخصوصية يذكرنا بما حدث عندما أطلقت جوجل خريطتها التفاعلية "جوجل ستريت فيو" في 2007، كما تقول الزميلة المختصة بالخصوصية وسياسات البيانات في معهد ستانفورد للذكاء الاصطناعي الذي يركز على البشر، جينيفر كينغ.

فقد كان الإصدار الأول من هذه الخدمة مصدر بهجة لمحبي التلصص، فقد كان النظام مليئاً بصور لأشخاص ينظفون أنوفهم، ورجال خارجين من الملاهي الليلية، وأشخاص يتشمسون دون أي حذر أو انتباه. كما قامت الشركة أيضاً بجمع بيانات حساسة، مثل كلمات المرور وعناوين البريد الإلكتروني، عبر شبكات واي فاي. وكانت النتيجة أن خدمة ستريت فيو تعرضت لانتقادات حادة، ودعوى قضائية بقيمة 13 مليون دولار، وحتى الحظر في بعض البلدان. واضطرت جوجل إلى تطبيق بعض الإجراءات لحماية الخصوصية، مثل تغشية بعض المنازل والوجوه والنوافذ ولوحات أرقام السيارات.

تقول كينغ: "من سوء الحظ، يبدو أن جوجل لم تأخذ أي عبرة مما حدث، وينطبق هذا على الشركات التكنولوجية الأخرى أيضاً".

نماذج أكبر، مخاطر أكبر

تحمل النماذج اللغوية الكبيرة المدربة على مقادير كبيرة من البيانات الشخصية مخاطر كثيرة.

ولا تقتصر مشكلاتها على أنها تقوم بإعادة صياغة معلوماتك على الإنترنت بشكل عشوائي وخارج عن السياق. بل تنطوي على بعض المخاطر الحقيقية المتعلقة بالأمن والسلامة. فقد يستطيع القراصنة استخدام النماذج لاستخلاص أرقام الضمان الاجتماعي أو عناوين المنازل.

كما أنه من السهل نسبياً على القراصنة التلاعب بمجموعات البيانات عمداً من أجل "تسميمها" ببيانات من اختيارهم للتسبب بثغرات تسمح بارتكاب اختراقات أمنية، كما يقول خبير الذكاء الاصطناعي في وكالة حماية البيانات الفرنسية (CNIL)، أليكسيس ليوتييه.

وحتى على الرغم من أن النماذج تبدو وكأنها تقوم بإطلاق المعلومات التي تم تدريبها عليها بصورة عشوائية، كما يقول ترامر، فمن المحتمل أن النموذج يمتلك معلومات شخصية أكثر مما هو واضح، "ونحن لا ندري فعلياً كيف يمكن دفع النموذج إلى الإفصاح عن كامل المعلومات الموجودة لديه".

وكلما تكرر ظهور شيء ما في مجموعة البيانات، ازداد احتمال ظهوره في مخرجات النموذج. وهو ما يمكن أن يؤدي بالنموذج إلى التأثير على الناس بإطلاق ترابطات خاطئة ومؤذية ولا تزول بسهولة.

وعلى سبيل المثال، إذا تكرر ذكر اسم "تيد كاتشينسكي" (وهو إرهابي قام بعدة عمليات تفجير في أميركا) وكلمة "إرهاب" بشكل مترافق في قاعدة البيانات، فقد يعتقد النموذج أن أي شخص يحمل اسم كاتشينسكي هو إرهابي.

وهو ما يمكن أن يحدث ضرراً فادحاً بسمعة بعض الأشخاص، كما اكتشفت مع كينغ عندما كنا نجري التجارب على بليندربوت من ميتا.

فماريا رينسكي "مارييتي" شاك ليست إرهابية، بل سياسية هولندية شهيرة، وعضو سابق في البرلمان الأوروبي. وتشغل شاك حالياً منصب مدير السياسات الدولية في مركز الشرطة السيبرانية في جامعة ستانفورد، كما أنها زميلة مختصة بالسياسة الدولية في معهد ستانفورد للذكاء الاصطناعي الذي يركز على البشر.

اقرأ أيضاً: نتائج تجربة مولد اللغة الجديد جي بي تي-3 من أوبن إيه آي تُظهر أنه جيد إلى حد مذهل

وعلى الرغم من كل هذا، فقد استنتج بليندربوت، وبشكل غريب، أنها إرهابية، موجهاً إليها هذه التهمة بصورة مباشرة دون سابق إنذار. كيف حدث هذا؟

قد يكون أحد الأدلة المحتملة مقال كتبته في صحيفة واشنطن بوست (Washington Post)، حيث تكررت كلمات "إرهاب" بمترادفاتها المختلفة ثلاث مرات.

وتقول ميتا إن استجابة بليندربوت هي نتيجة عملية بحث فاشلة وقيام النموذج بصياغة معلومتين منفصلتين ضمن جملة مترابطة، وإن كانت غير صحيحة. وتشدد الشركة على أن النموذج ليس سوى عمل تجريبي للأغراض البحثية، وغير مستخدم في أي عملية إنتاجية.

تقول المسؤولة الإدارية لأبحاث الذكاء الاصطناعي الأساسية في ميتا، جويل بينو: "مع أن رؤية بعض هذه الاستجابات المسيئة أمر مؤلم، إلا أن هذه التجارب العلنية مهمة لبناء أنظمة ذكاء اصطناعي حوارية بتصاميم مدروسة، وإصلاح الثغرات الواضحة الحالية قبل استخدام هذه الأنظمة على الصعيد الإنتاجي".

ولكن إصلاح هذه المشكلات ليس بالأمر السهل على الإطلاق، لأن هذه التصنيفات شديدة الاستعصاء. فإزالة المعلومات عن الإنترنت صعبة للغاية، وسيكون حتى من الأصعب على الشركات التكنولوجية أن تزيل بيانات تم تلقيمها إلى نماذج ضخمة، ومن الممكن أنه تم تطوير هذه النماذج إلى عدد كبير من المنتجات التي أصبحت قيد الاستخدام.

وإذا كنت تعتقد أن هذه النتائج مخيفة، فسوف تفاجأ بما هو أسوأ مع الجيل التالي من النماذج اللغوية الكبيرة، والتي سيتم تلقيمها بمقدار أكبر حتى من البيانات. يقول ترامر: "هذه إحدى المشكلات التي ستتفاقم مع تضخم النماذج".

ولا تقتصر المشكلات على البيانات الشخصية. فمن المرجح أن تتضمن مجموعات البيانات بيانات مشمولة بحقوق النشر، مثل التعليمات البرمجية المصدرية والكتب، كما يقول ترامر. فقد تم تدريب بعض النماذج على بيانات مأخوذة من موقع "غيت هاب" (GitHub)، وهو موقع يتيح لمطوري البرمجيات متابعة عملهم.

وهو ما يثير بعض التساؤلات الصعبة، حيث يقول ترامر:

"قد تستطيع هذه النماذج تذكر أجزاء معينة من التعليمات البرمجية، ولكنها لن تحتفظ بالضرورة بمعلومات الترخيص. فإذا استخدمت أحد هذه النماذج، وقدم لك كتلة من التعليمات البرمجية التي تبدو، وبوضوح، منسوخة من مكان آخر، فمن سيتحمل المسؤولية في هذه الحالة؟"

اقرأ أيضاً: النماذج الافتراضية الأولية تساعد في تقييم المنتجات الجديدة وتحسينها

حدث أمر مماثل بضع مرات مع باحث الذكاء الاصطناعي والزميل في مرحلة ما بعد الدكتوراة في معهد جورجيا للتكنولوجيا، والذي أنهى درجة الدكتوراة حول التعلم المعزز على الروبوتات في جامعة جونز هوبكنز في الخريف الماضي، آندرو هونت.

ففي المرة الأولى، في فبراير/ شباط، قام باحث مختص بالذكاء الاصطناعي في مدينة بيركلي بكاليفورنيا -ولا توجد معرفة سابقة بينه وبين هونت- بالإشارة إلى هونت في تغريدة تقول إن كوبايلوت -وهو برنامج مشترك بين أوبن أيه آي وغيت هاب، ويتيح للباحثين استخدام النماذج اللغوية الكبيرة لتوليد التعليمات البرمجية- بدأ بإنتاج كتل نصية تتضمن اسم المستخدم الخاص بهونت على غيت هاب مع عبارات حول الذكاء الاصطناعي والروبوتات بصياغة شبيهة بقوائم المهام التي كان هونت يضعها.

ويقول هونت: "لقد تفاجأت بظهور معلوماتي الشخصية بهذه الطريقة على حاسوب شخص آخر في الطرف الآخر من البلاد، وفي مجال مقارب لمجال عملي".

ويضيف هوت قائلاً إن هذا قد يتسبب بالعديد من المشكلات لاحقاً. ولا تقتصر المشكلات على احتمال ارتكاب أخطاء في أسماء المؤلفين، ولكن التعليمات البرمجية قد لا تحمل معها أي معلومات حول تراخيص وقيود البرنامج.

على المحك

إن تجاهل الخصوصية قد يعني وقوع الشركات التكنولوجية في متاعب مع الجهات التكنولوجية المنظمة المتشددة بصورة متزايدة.

تقول جينيفر كينغ من ستانفورد: "إن الذريعة التي تقول ’’إنه عمل عام ولا داعي للاكتراث بالنتائج‘‘ لن تصمد لوقت طويل".

فهيئة التجارة الفيدرالية في الولايات المتحدة تدرس فرض قواعد حول عمليات جمع البيانات ومعالجتها وبناء الخوارزميات لدى الشركات، كما أرغمت الشركات على حذف النماذج التي تحتوي على بيانات مخالفة للقانون. وفي مارس/ آذار من عام 2022، أرغمت الوكالة شركة ويت ووتشرز (Weight Watchers) المختصة بالحميات الغذائية على حذف بياناتها وخوارزمياتها بعد قيامها بجمع معلومات عن الأطفال بشكل غير قانوني.

تقول كينغ: "يمكن أن نضع هذه الشركات على المحك لدفعها إلى تفكيك هذه الأنظمة وإيجاد طرق لإزالة بعض البيانات منها". "ولا أعتقد أنه يمكننا الاكتفاء بالتعايش مع الوضع الحالي".

وحتى لو كانت هذه البيانات مستخلصة من الإنترنت، فإن الشركات ما زالت ملزمة بالامتثال لقوانين حماية البيانات الأوروبية. يقول فيليسيان فاليه، والذي يقود فريقاً من الخبراء التقنيين في CNIL: "لا يمكنك إعادة استخدام أي بيانات لمجرد أنها متاحة للعموم".

اقرأ أيضاً: استخدم أدوات الأمن السيبراني هذه لحماية أجهزتك من الاختراق

وهناك سابقة لعقاب الشركات التكنولوجية وفق النظام الأوروبي العام لحماية البيانات بسبب استخلاصها للبيانات من شبكة الإنترنت العامة. فقد تلقت شركة تكنولوجيا التعرف على الوجوه كليرفيو أيه آي (Clearview AI) أوامر من عدة وكالات أوروبية لحماية البيانات بالتوقف عن إعادة استخدام الصور المتاحة للعموم من الإنترنت لبناء قاعدة البيانات الخاصة بها للوجوه.

يضيف فاليه قائلاً: "عند جمع البيانات لبناء النماذج اللغوية أو غيرها من نماذج الذكاء الاصطناعي، ستواجه نفس المشكلات، ويجب أن تحرص على أن عملية إعادة استخدام البيانات غير مخالفة للقانون".

لا حلول سريعة

هناك بعض الجهود الرامية إلى تعزيز الاهتمام بمسائل الخصوصية في حقل التعلم الآلي. فقد عملت وكالة حماية البيانات الفرنسية مع شركة الذكاء الاصطناعي الناشئة هاغينغ فيس (Hugging Face) لزيادة الوعي بالمخاطر المتعلقة بحماية البيانات في النماذج اللغوية الكبيرة أثناء تطوير نموذج بلوم اللغوي الجديد المتاح للعموم (BLOOM). وقد قالت لي باحثة الذكاء الاصطناعي وأخصائية الأخلاقيات في هاغينغ فيس، مارغريت ميتشل، إنها تعمل أيضاً على بناء مجموعة معايير للخصوصية في النماذج اللغوية الكبيرة.

كما تعمل مجموعة تطوعية تفرعت عن مشروع هاغينغ فيس لتطوير بلوم على بناء معيار للخصوصية في الذكاء الاصطناعي بشكل يصلح للاستخدام في كافة النطاقات.

تقول الشريكة الاستثمارية في ماتار فينتشرز (MATAR Ventures) والمشاركة في قيادة المشروع، هيسي جونز: "ما نحاول تحقيقه هو استخدام إطار عمل يتيح للناس وضع تقييمات جيدة حول مدى الحاجة الفعلية إلى وجود معلومات معينة شخصية أو قابلة للربط مع هوية معينة".

وقد وجهت إم آي تي تكنولوجي ريفيو أسئلة إلى جوجل وميتا وأوبن أيه آي وديب مايند (Deepmind)، وجميعها شركات قامت بتطوير أحدث الأنظمة اللغوية الكبيرة، حول مقاربتها لمسائل الخصوصية في الأنظمة اللغوية الكبيرة. وقد اعترفت جميع الشركات بأن حماية البيانات في النماذج اللغوية الكبيرة مشكلة حقيقية وما زالت موجودة، وأنه لا توجد حلول مثالية للتخفيف من أضرارها، وأن مخاطر هذه النماذج وحدودها ما زالت غير مفهومة تماماً حتى الآن.

اقرأ أيضاً: 5 طرق فعالة لحماية هويتك الرقمية على الإنترنت

ولكن المطورين يمتلكون بعض الأدوات، وإن كانت غير مثالية.

ففي بحث نُشر في بداية عام 2022، يقول ترامر وزملاؤه المؤلفون إنه يجب تدريب النماذج اللغوية باستخدام بيانات تم إنتاجها بشكل صريح للاستخدام العام، بدلاً من جمع البيانات المتاحة أمام الجميع.

غالباً ما تنتشر البيانات الخاصة عبر مجموعات البيانات المستخدمة لتدريب النماذج اللغوية الكبيرة، وهي بيانات تم جمع نسبة كبيرة منها من شبكة الإنترنت المفتوحة للجميع. وكلما زاد ظهور وتكرار هذه الأجزاء من المعلومات الشخصية في بيانات التدريب، زاد احتمال تذكر النموذج لها، وأصبح ترابطها أكثر قوة. ومن الأساليب التي تقول الشركات مثل جوجل وأوبن أيه آي إنها تستخدمها للتخفيف من هذه المشكلة، إزالة المعلومات التي تظهر عدة مرات في مجموعات البيانات قبل تدريب النماذج عليها. ولكن استخدام هذا الأسلوب صعب للغاية عندما يصل حجم مجموعة البيانات إلى مستويات هائلة من رتبة الغيغابايت أو التيرابايت، ويجب التمييز بين النص الذي لا يحتوي أي معلومات شخصية، مثل نص إعلان الاستقلال الأميركي، وعنوان منزل شخص ما.

تعتمد جوجل على مدققين بشر لتصنيف المعلومات التي يمكن ربطها بمعلومات شخصية على أنها غير آمنة، ما يساعد على تدريب النموذج اللغوي الكبير لامدا الذي صممته الشركة على تفادي تكرار هذه المعلومات، كما تقول مسؤولة قسم إنتاج الحلول القائمة على الذكاء الاصطناعي المسؤول في جوجل، دولسي دوشي.

كما قال متحدث باسم أوبن أيه آي إن الشركة "اتخذت بعض الخطوات لإزالة أي مصادر معروفة تتضمن كتلاً من المعلومات الشخصية من بيانات التدريب، وقامت بتطوير عدة تقنيات لتخفيض احتمال ظهور معلومات شخصية في مخرجات النموذج".

اقرأ أيضاً: ما الذي يجب أن تفعله لحماية خصوصيتك من تجسس إنترنت الأشياء؟

وتقول باحثة الذكاء الاصطناعي في ميتا، سوزان زانغ، إن قواعد البيانات التي تم استخدامها لتدريب "أو بي تي 175 بي" خضعت لعدة عمليات تدقيق داخلية لحماية الخصوصية.

ولكن، وكما يقول ترامر: "حتى لو تم تدريب النموذج بأشد إجراءات الخصوصية صرامة في الوقت الحالي، فليس هناك أي شيء مضمون".