في مطلع القرن العشرين، قال الفيلسوف الإسباني جورج سانتيانا: "أولئك الذين لا يتذكرون الماضي محكوم عليهم تكراره". واليوم، يشعر مطورو برامج الذكاء الاصطناعي أنهم أكثر المعنيين بهذه الحكمة.

نسمع مرة تلو أخرى عن حالات فشل لأنظمة الذكاء الاصطناعي حتى لم نعد نميز ما إذا كان الخبر حديثاً أم هو نفس الحادث الذي قرأنا عنه قبل شهر. ويشمل ذلك تحيز خوارزميات الإقراض ضد النساء وعنصرية خوارزميات التعرف على الوجوه ضد ذوي البشرة السمراء وترويج أنظمة التوصية على منصات التواصل الاجتماعي للمحتوى العنيف أو لنظريات المؤامرة، والقائمة تطول.

ما الحلّ؟ لا بدّ أن نتعلم من أخطائنا وأخطاء غيرنا حتى نتجنب الوقوع فيها مرة أخرى، ويجب أن نبدأ بتجميع حالات الفشل لأنظمة الذكاء الاصطناعي المستخدمة على أرض الواقع، ومن ثم إتاحتها للجميع من أجل الاطلاع والإضافة عليها.

قاعدة بيانات حوادث الذكاء الاصطناعي

هذا بالضبط ما سعت لتحقيقه مؤسسة الشراكة حول الذكاء الاصطناعي (PAI) التي تضم عدداً من المنظمات غير الربحية بالإضافة إلى شركات التكنولوجيا العملاقة مثل آبل وجوجل وأمازون وفيسبوك وآي بي إم ومايكروسوفت. وتعنى هذه المؤسسة بتطوير أفضل الممارسات في مجال الذكاء الاصطناعي وتحسين فهم الجمهور لتقنياته وتقليل مخاطره المحتملة.

بتمويل من مؤسسة الشراكة حول الذكاء الاصطناعي، تم إطلاق قاعدة بيانات حوادث الذكاء الاصطناعي (AIID) التي تهدف إلى تسهيل وصول العاملين في مجال الذكاء الاصطناعي إلى هذه الحوادث أو حالات الفشل ودراستها لتجنب تكرارها ومنع خوارزميتهم من التسبب بالأذى، أو على الأقل تقليل تواترها وتخفيف حدة تأثيراتها.

تستوحي قاعدة البيانات هذه تصميمها وبنيتها إلى حد ما من قواعد بيانات حوادث الطيران؛ حيث لعبت قواعد البيانات هذه دوراً هاماً في زيادة أمان رحلات الطيران من خلال تحليل وأرشفة الحوادث والأخطاء السابقة. وبالمثل، من شأن قاعدة بيانات خاصة بحوادث الذكاء الاصطناعي أن تنشر المعرفة وتساهم في تحسين أمان وأخلاقيات أنظمة الذكاء الاصطناعي قبل استخدامها في تطبيقات حقيقية.

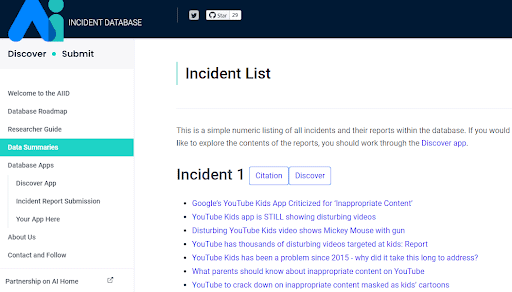

تضم قاعدة بيانات حوادث الذكاء الاصطناعي أكثر من 1,000 حالة فشل لأنظمة الذكاء الاصطناعي في العالم الحقيقي بناء على ما أوردته وسائل الإعلام والمصادر الأخرى المفتوحة. وتغطي هذه الحوادث نطاقاً واسعاً من المشاكل مثل أنظمة توصية الفيديوهات للأطفال على يوتيوب التي تقترح محتوى غير لائق، وحوادث السيارات ذاتية القيادة، والأخطاء القاتلة لروبوتات العمليات الجراحية، وعنصرية بوتات الدردشة وخوارزميات تقييم المخاطر المستخدمة في الأنظمة القضائية، والتحيز والتمييز على أساس الجنس أو العرق أو الإعاقة في خوارزميات التوظيف القائمة على الذكاء الاصطناعي وغيرها.

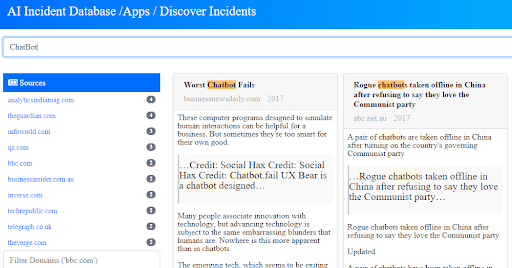

ويمكن لأي شخص استعراض هذه الحوادث والبحث فيها تبعاً للمصدر أو رقم الحادث أو كلمة مفتاحية. وعلى سبيل المثال عند البحث عن مصطلح بوت الدردشة "ChatBot"، تحصل على 69 تقرير حول حالات فشل لهذه الأنظمة.

حالات استخدام عملية لقاعدة البيانات

من شأن قاعدة البيانات الموحدة لحوادث أنظمة الذكاء الاصطناعي أن تخدم أغراضاً مختلفة في عدة مجالات تبعاً لعمل الشخص الذي يستخدمها:

مديرو المنتجات

إذا اكتشف مدير المنتج أن أحد الأنظمة الذكية قد تسببت بأضرار عند استخدامها في الماضي، فيمكنه إضافة شروط إضافية أثناء عملية التطوير لتقليل مخاطر تكرار الأذى. وعلى سبيل المثال، عند العمل على تصميم خوارزمية توصية للأطفال، يمكن لمدير المنتج أن يكتشف الحادث رقم 1 والذي يشير إلى أن يوتيوب كيدز (Youtube Kids) قد أوصى سابقاً بمحتوى غير مناسب للأطفال. وبالتالي يقوم بوضع مجموعة من الشروط التقنية والتسويقية التي تدفع فريق التطوير إلى تفادي الوقوع في هذا الخطأ.

مسؤولو إدارة المخاطر

تساعد قاعدة البيانات على اتخاذ قرارات أفضل لتجنب بعض المخاطر. وعلى سبيل المثال، عند العمل على تطوير نظام ترجمة آلية، فإن قاعدة البيانات تحتوي العديد من التقارير عن أخطاء هذه الأنظمة بما فيها الحادث رقم 72 الذي يحتوي تقارير عن اعتقال رجل فلسطيني بعد أن قام نظام الترجمة الآلية في فيسبوك بترجمة تحيته الصباحية "يصبحهم" باللغة العربية إلى "هاجمهم" باللغة العبرية. بعد اكتشاف هذا الحادث، يمكن لمسؤول إدارة المخاطر قراءة التقارير والتحليلات لمعرفة أنه من المستحيل حالياً منع حدوث هذا النوع من الأخطاء تقنياً، ولكن هناك مجموعة متنوعة من أفضل الممارسات في التخفيف من المخاطر مثل الإشارة بوضوح إلى أن النص هو نتاج ترجمة آلية وقد يتضمن أخطاء.

المهندسون

يمكن للمهندسين أيضاً الاستفادة من قاعدة بيانات حوادث الذكاء الاصطناعي لتعلم المزيد عن العالم الحقيقي الذي يتم نشر أنظمتهم فيه. وعلى سبيل المثال، عندما يعمل مهندس على تطوير سيارة ذاتية القيادة مزودة بنظام للتعرف على الصور. يبين الحادث رقم 36 أن نظام التعرف على الوجوه قد أخطأ بإصدار مخالفة لامرأة في الصين بسبب عبورها الشارع بطريقة غير قانونية لكن في الواقع كانت صورة المرأة موجودة على جانب أحد الحافلات. وبالتالي، يحث ذلك المهندس على تضمين هذه الحالات في اختبارات السلامة أثناء إجراء التجارب على أنظمة الرؤية في السيارة.

الباحثون

يستخدم الباحثون في مجال السلامة والإنصاف بالفعل منهجيات دراسة الحالات في أبحاثهم، لكنهم يفتقرون حالياً إلى القدرة على تتبع حوادث الذكاء الاصطناعي على مستوى السكان. وعلى سبيل المثال، يمكنهم البحث في قاعدة البيانات من الحصول على العديد من الحالات الموثقة لحوادث حقيقية والاستشهاد بها في أوراقهم البحثية. ويمكنهم بعد ذلك إضافة الأوراق البحثية الناتجة إلى قاعدة البيانات كتقرير إضافي عن الحادث. بالإضافة إلى ذلك، يمكن للباحثين إظهار أهمية مقالاتهم العلمية من خلال الاستشهاد بالحوادث التي تتيح أبحاثهم التخفيف من حدتها وأضرارها.

يأمل القائمون على هذا المشروع أنه بمرور الوقت ستوفر قاعدة البيانات هذه تغطية أكبر لحوادث الذكاء الاصطناعي وتخفيف التأثيرات السلبية لاستخدام أنظمة الذكاء الاصطناعي في العالم الحقيقي. ويقولون إنه حتى قبل نشر قاعدة البيانات، تلقوا طلبات تعاون من العديد من شركات المحاسبة والاستشارات الدولية ومكاتب المحاماة والمعاهد البحثية والأكاديميين وغيرهم.