حيثيات الخبر

من أهم عيوب التعلم العميق -التي ما زالت من دون حلول حتى الآن- ضعفُه إزاء ما يسمى بالهجمات التنافسية. عندما تضاف هذه التشويشات -التي قد تبدو عشوائية أو عصية على الكشف بالعين المجردة- إلى مُدخلات نظام الذكاء الاصطناعي، يمكن أن تؤدي إلى تغيير كامل في النتائج. وعلى سبيل المثال، يمكن أن تؤدي مُلصقات وُضِعت بعناية على إشارة توقف إلى خداع سيارة ذاتية القيادة، بحيث ترى بدلاً من ذلك إشارة تحدد السرعة المسموحة، على حين أن الملصقات على الطريق يمكن أن تؤدي إلى إرباك سيارة تسلا وحرفِها إلى المجاز الخاطئ على الطريق.

السلامة الحرجة

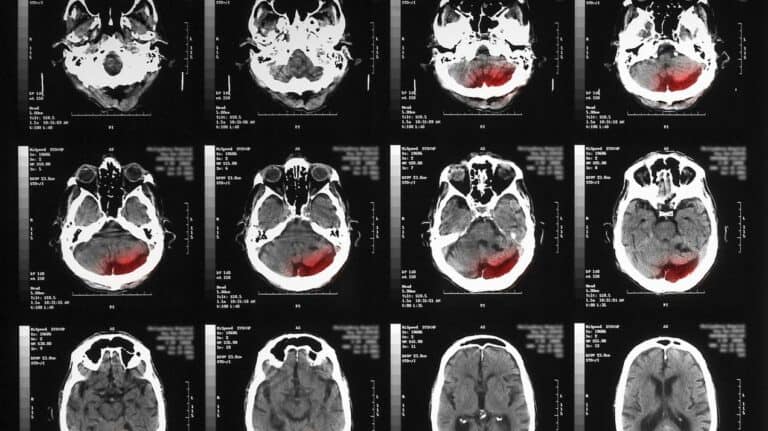

تركز معظم أبحاث الهجمات التنافسية على أنظمة التعرف على الصور، ولكن أنظمة إعادة تركيب الصور التي تعتمد على التعلم العميق هي أيضاً عرضة لهذه الهجمات. هذا مثير للقلق على وجه الخصوص في مجال الرعاية الصحية، حيث تُستخدم هذه الأنظمة في أغلب الأحيان لإعادة تركيب الصور الطبية، مثل صور الأشعة المقطعية أو الرنين المغناطيسي من بيانات المسح بالأشعة السينية. يمكن أن يؤدي هجوم تنافسي إلى ظهور ورم في الصورة المعاد تركيبها على الرغم من عدم وجوده فعلياً.

البحث

قامت بو لي (وهي من قائمة مبتكرون دون 35 لإم آي تي تكنولوجي ريفيو هذا العام) ومجموعة من زملائها في جامعة إيلينويس في أوربانا شامباين، باقتراح طريقة جديدة لتدريب أنظمة التعلم العميق بحيث تكون أكثر مقاومة للفشل وأكثر وثوقية في الأوضاع الحساسة. قام الباحثون بإجراء مواجهة بين شبكة عصبونية مسؤولة عن إعادة تركيب الصور وشبكة عصبونية مسؤولة عن توليد أمثلة هجمات تنافسية، بشكل مشابه لخوارزميات الشبكات العصبونية التنافسية التوليدية. في كل دورة من المواجهة، كانت الشبكة التنافسية تحاول خداع شبكة إعادة التركيب ودفعها إلى إنتاج أشياء لا تمثل جزءاً من البيانات الأصلية أو ليست حقيقية. كانت شبكة إعادة التركيب تعدل نفسها باستمرار لتفادي التعرض للخداع، ما يجعل تطبيقها في العالم الحقيقي أكثر أماناً.

النتائج

عندما اختبر الباحثون شبكتهم تنافسية التدريب على مجموعتين ذائعتي الصيت من بيانات الصور، تمكنت من إعادة تركيب الواقع الحقيقي بشكل أفضل من الشبكات الأخرى التي كانت "محصنة" بأساليب أخرى. غير أن النتائج ما زالت غير مثالية، وهو ما يبيّن أن الطريقة ما زالت في حاجة إلى التنقيح. سيتم تقديم هذا العمل قريباً في المؤتمر الدولي للتعلم الآلي.