أعلنت جوجل مؤخراً خلال مؤتمر آي أو (I/O) الذي تعقده سنوياً عن خططها لإدماج أدوات الذكاء الاصطناعي في جميع منتجاتها عملياً، بدءاً من جوجل دوكس (Google Docs) وصولاً إلى خدمات البرمجة والبحث عبر الإنترنت. يمكنكم قراءة مقالي عن هذا الموضوع هنا.

يمثل إعلان جوجل خبراً فائق الأهمية؛ فسوف يصبح بوسع المليارات من الأشخاص استخدام نماذج الذكاء الاصطناعي الحديثة والعالية القدرة في مختلف أنواع المهام، مثل توليد النصوص والإجابة عن الأسئلة وكتابة التعليمات البرمجية وتصحيح أخطائها.

نهج جوجل في تبني الذكاء الاصطناعي التوليدي

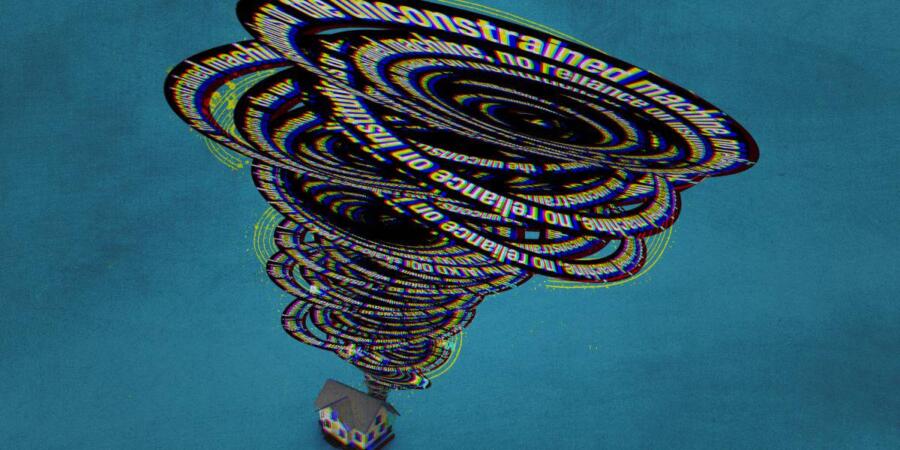

تعتمد جوجل نهجاً قائماً على تزويد منتجاتها بهذه الوظائف تدريجياً، إلا أنه من المرجح ألا يمر وقت طويل حتى تخرج الأمور عن السيطرة، إذ لم تقدم الشركة حتى الآن أي حلول للمشاكل الشائعة في نماذج الذكاء الاصطناعي هذه؛ فما زالت هذه النماذج تبتدع المعلومات، وما زال من السهل خداعها ودفعها إلى انتهاك قواعد العمل الخاصة بها. وما زالت عرضة للهجمات والاختراق، ولا يكاد يوجد ما يمنع استخدامها في نشر المعلومات المزيفة والاحتيال والإزعاج.

ولأن هذه الأنواع من أدوات الذكاء الاصطناعي ما تزال جديدة نسبياً، فهي ما زالت تعمل إلى حد كبير دون أي قوانين ناظمة لعملها، لكن هذا الوضع لا يمكن أن يدوم طويلاً، فقد بدأت النداءات الداعية إلى التنظيم تتعالى مع تلاشي البهجة والحماسة المرافقتين لإطلاق تشات جي بي تي (ChatGPT)، وبدأ المشرّعون يطرحون الأسئلة الصعبة والحاسمة المتعلقة بهذه التكنولوجيا.

اقرأ أيضاً: كيف ستربح آبل من ثورة الذكاء الاصطناعي التوليدي؟

إدارة أدوات الذكاء الاصطناعي المتطورة

يسعى المشرعون الأميركيون للتوصل إلى طريقة لإدارة عمل أدوات الذكاء الاصطناعي المتطورة، ومن المقرر أن يقدم الرئيس التنفيذي لشركة أوبن أيه آي (OpenAI)، سام ألتمان، شهادته في مجلس الشيوخ الأميركي بعد عشاء "ثقافي" ودي رفقة السياسيين في الليلة السابقة لهذه الشهادة. وفي الأسبوع السابق لجلسة الاستماع هذه، عقدت نائبة الرئيس كامالا هاريس اجتماعاً مع الرؤساء التنفيذيين لشركات ألفابت (Alphabet) ومايكروسوفت (Microsoft) وأوبن أيه آي وأنثروبيك (Anthropic)،

وقالت في تصريح لها إن الشركات تتحمل "مسؤولية أخلاقية ومعنوية وقانونية" لضمان أمان منتجاتها. اقترح السيناتور تشاك شومر -زعيم الأغلبية- عن ولاية نيويورك، تشريعاً لتنظيم الذكاء الاصطناعي، ومن المحتمل أن يتضمن تأسيس هيئة جديدة لفرض هذه القوانين.

تقول الزميلة المختصة بسياسات الخصوصية والبيانات في معهد ستانفورد للذكاء الاصطناعي الذي يتمحور حول البشر، جينيفر كينغ: "يرغب الجميع في أن يظهروا بمظهر المسهم في حل هذه المشكلة. وثمة درجة عالية من القلق الاجتماعي إزاء التقلبات الحالية".

اقرأ أيضاً: كيف سنواجه تهديد الذكاء الاصطناعي التوليدي بزيادة نفوذ الشركات التكنولوجية الكبرى؟

التوصل إلى تشريع يُرضي الجميع

سيكون من الصعب حشد تأييد كلا الحزبين الرئيسيين لقانون جديد حول الذكاء الاصطناعي، كما تقول كينغ: "سيعتمد الأمر على درجة اعتبار المشرعين الذكاء الاصطناعي التوليدي خطراً حقيقياً على المجتمع". ولكنها تضيف قائلة إن رئيسة مجلس إدارة هيئة التجارة الفيدرالية، لينا خان، اندفعت نحو هذه المسألة "بكل ما أوتيت من حماس". ففي وقت سابق من هذا الشهر مايو/ أيار، كتبت خان مقالاً دعت فيه إلى تنظيم الذكاء الاصطناعي على الفور لتلافي الأخطاء التي نجمت عن التراخي مع قطاع التكنولوجيا في الماضي، وأشارت إلى أن المشرعين الأميركيين سيلجؤون، على الأرجح، إلى استخدام القوانين القائمة بالفعل ضمن حزمة الأدوات التشريعية التي يعتمدونها لتنظيم الذكاء الاصطناعي، مثل قوانين مكافحة الاحتكار والممارسات التجارية.

في هذه الأثناء، يقترب المشرعون في أوروبا من التوصل إلى اتفاق نهائي على الصيغة النهائية لقانون الذكاء الاصطناعي، فقد وقّع بعض أفراد البرلمان الأوروبي مؤخراً مسودة لائحة تنظيمية تدعو إلى حظر تكنولوجيا التعرف على الوجوه في الأماكن العامة، إضافة إلى أنها تحظر استخدام تكنولوجيا الحماية التنبؤية والتعرف على المشاعر وتجميع بيانات القياسات الحيوية العشوائي من الإنترنت.

اقرأ أيضاً: ما ملامح المرحلة التالية في مجال الذكاء الاصطناعي التوليدي؟

بانتظار قواعد الاتحاد الأوروبي

من المقرر أن يضع الاتحاد الأوروبي المزيد من القواعد الناظمة لعمل الذكاء الاصطناعي التوليدي أيضاً، ويرغب البرلمان في أن تتحلى الشركات التي تتولى بناء نماذج الذكاء الاصطناعي الضخمة بالمزيد من الشفافية. وتتضمن هذه القواعد وضع علامات مميزة على المحتوى الذي يولده الذكاء الاصطناعي، ونشر ملخصات حول البيانات التي تشملها قوانين حماية الملكية الفكرية والتي استُخدِمت في تدريب النموذج، وفرض إجراءات وقائية تمنع النماذج من توليد المحتوى المخالف للقانون.

ولكن ثمة ناحية سلبية، فما زال الاتحاد الأوروبي بعيداً عن تطبيق القوانين على الذكاء الاصطناعي التوليدي، إضافة إلى أن الكثير من العناصر المقترحة لقانون الذكاء الاصطناعي لن تكون موجودة ضمن نسخته النهائية، وما زال هناك الكثير من المفاوضات الصعبة بين البرلمان والمفوضية الأوروبية والبلدان الأعضاء في الاتحاد الأوروبي، ولن نشهد التطبيق العملي لقانون الذكاء الاصطناعي قبل سنوات.

اقرأ أيضاً: ما مصير الذكاء الاصطناعي التوليدي بعد أن يخبو الضجيج الإعلامي؟

نافذة أوفرتون

وفي حين يواجه المشرّعون صعوبة في تحقيق أثر ملموس، بدأت بعض الأصوات البارزة في مجال التكنولوجيا بمحاولة تغيير الأفكار المقبولة في النطاق العام، والتي تُعرف بنافذة أوفرتون أو نافذة الخطاب (Overton window). ففي حدث أُقيم مؤخراً، قال كبير الاقتصاديين في مايكروسوفت، مايكل شوارتز، إننا يجب أن ننتظر حتى نرى "ضرراً حقيقياً" بسبب الذكاء الاصطناعي قبل تنظيمه، وقارن هذه المسألة برخصة القيادة، التي فُرِضت بعد مقتل العشرات من الأشخاص في حوادث السيارات. قال شوارتز: "يجب أن نشهد قدراً ضئيلاً من الأضرار على الأقل كي نتمكن من تحديد المشكلة الحقيقية".

إنه تصريح فاضح يثير أشد الاستياء؛ فقد تم توثيق الأضرار التي تسبب بها الذكاء الاصطناعي على مدى عدة سنوات، ومنها التحيز والتمييز والأخبار المزيفة الموَلّدة باستخدام الذكاء الاصطناعي وعمليات الاحتيال. وقد تسببت أنظمة ذكاء اصطناعي أخرى باعتقال أناس أبرياء، وإبقاء آخرين في حالة من الفقر، وبالاتهام الخاطئ لعشرات الآلاف من الأشخاص بالاحتيال. من المرجح أن تتزايد هذه الأضرار بوتيرة متسارعة مع زيادة تغلغل الذكاء الاصطناعي التوليدي في مجتمعنا، وذلك بفضل المشاريع الشبيهة بما أعلنت عنه جوجل.

يجب أن نوجه لأنفسنا السؤال التالي: ما مقدار الضرر الإضافي الذي يجب أن نراه حتى نبدأ بمواجهة هذه المشكلة؟ أعتقد أننا رأينا ما يكفي.