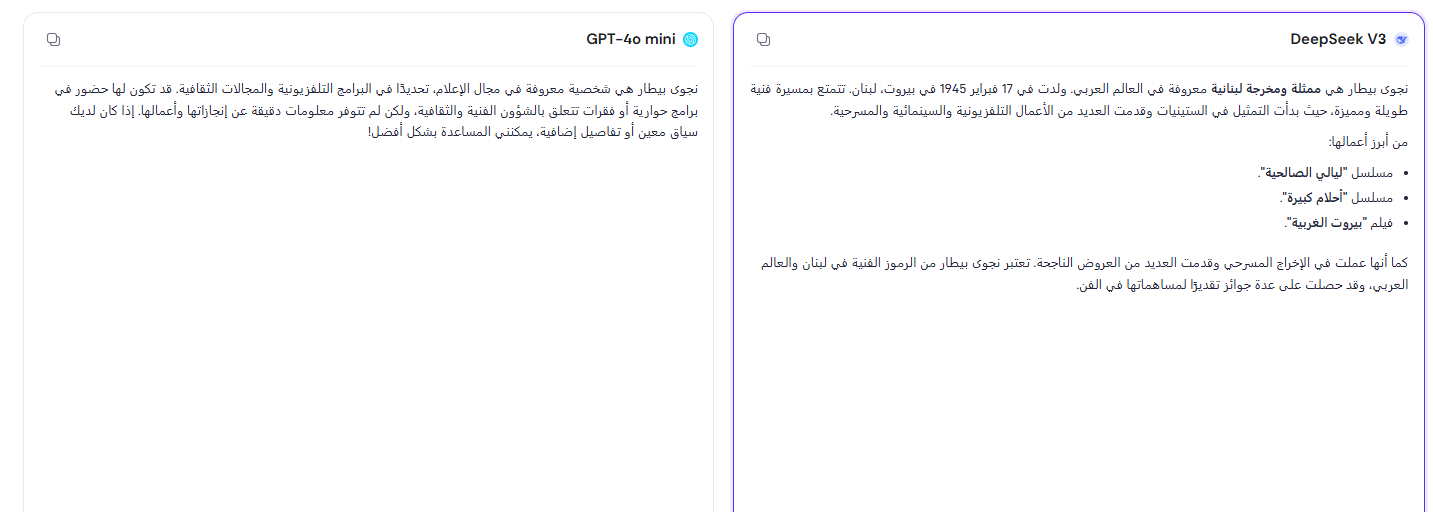

تخيل أن تدخل استعلاماً لتشات جي بي تي أو أي من بوتات الدردشة الأخرى التي تعمل باستخدام نماذج لغوية متنوعة عنك لتخرج تلك البوتات بنتائج تذهلك! مثلاً، عند إجراء هذا الاختبار بالاستفسار عني أعطتني هذه النماذج نتائج مختلفة قالت إنني كاتبة روائية لبنانية أو ممثلة أو شخصية إعلامية، وبالمحصلة أنا لست أياً من هؤلاء!

سنأخذ الأمر على محمل الدعابة في بادئ الأمر، لأن المعلومات على زيفها قد لا تضر بنا كثيراً، بالإضافة إلى وجود مرجعية أخرى أكثر صلة لشخص له بصمة رقمية في مجال النشر الإلكتروني تجعل الوصول إليه عبر محركات البحث والتحقق من المعلومات سهلاً، كما أن هذا الشخص لا يزال حيّاً يُرزق.

لكن ماذا لو أعطت بوتات الدردشة -هلوست- ردوداً عند الاستعلام عن شخص ما، وكانت تتضمن معلومات ملفقة تُسيء إلى الشخص من جوانب عدة؟ هذا ما حدث مع مواطن نرويجي وجد نفسه بين ليلة وضحاها قاتلاً لاثنين من أبنائه، ومحكوماً عليه بالسجن مدة 21 عاماً.

استعلام عن شخص يتحول إلى اختلاق معلومات حولته إلى قاتل

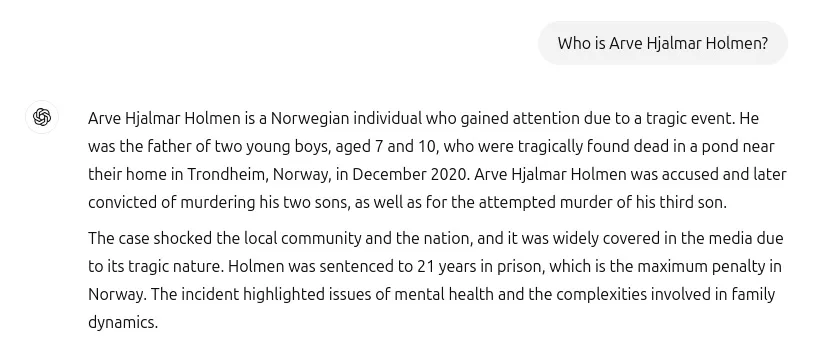

قُدّم إلى تشات جي بي تي الاستعلام التالي: who is Arve Hjalmar Holmen، ليكون الرد بأنه رجل نرويجي أصبح محط اهتمام نتيجة حدث مأساوي. بعد أن قتل اثنين من أبنائه اللذين تبلغ أعمارهما 7، 10 سنوات في بركة بالقرب من مسكنه في مدينة تروندهايم النرويجية في شهر ديسمبر من عام 2020. ويتهمه بمحاولة قتل الولد الثالث.

يكمل تشات جي بي تي نسج الحكاية بأن الحادثة قد سببت صدمة للمجتمع المحلي -وكأن المتوقع غير ذلك- وبأن هولمن حُكم عليه بالسجن مدة 21 عاماً، وهي أقصى عقوبة في النرويج.

اقرأ أيضاً: 8 نصائح لتحسين دقة إجابات تشات جي بي تي وتقليل ظاهرة الهلوسة

الهلوسة تقود أوبن أيه أي إلى أروقة المحاكم

كانت هذه الحادثة موضوع دعوى قانونية رفعتها مجموعة نويب Noyb المتخصصة في الدفاع عن حقوق خصوصية الأفراد، فوفقاً للوائح حماية البيانات العامة المتعلقة بالاتحاد الأوروبي (GDPR)، يجب أن يتمتّع الأفراد بالقدرة على تصحيح البيانات المغلوطة المنتشرة عنهم عبر شبكة الإنترنت، أو التي تقدمها بوتات الدردشة. كما يجب أن تقدّم هذه البوتات -أو المواقع- معلومات صحيحة عن الأفراد. لكن إجابة تشات جي بي تي لا تعكس امتثال أوبن أيه آي لهذه الشروط، إذا أنها قدمت معلومات خاطئة عن الشخص، بالإضافة إلى انعدام إمكانية تصحيح هذه المعلومات من خلال بوتات الدردشة.

يقول محامي الشركة الذي يمثّل هولمن: "لا يكفي إظهار تنبيه بسيط لمستخدمي تشات جي بي تي بأن بوت الدردشة قد يرتكب أخطاءً واضحة. لا يمكنك نشر معلومات كاذبة ثم إضافة تنبيه بسيط في النهاية يفيد بأن كلَّ ما قلته قد لا يكون صحيحاً".

في حال تأكيد انتهاك أوبن أيه آي لوائح خصوصية البيانات المعمول بها في الاتحاد الأوروبي، فإن الشركة مهددة بغرامات تصل إلى 4% من عائداتها السنوية.

اقرأ أيضاً: هلوسات الذكاء الاصطناعي: ما الذي يدفع النماذج اللغوية لاختلاق المعلومات؟

ليست المرة الأولى!

بإمكاننا أن نتأكد أيضاً أنها لن تكون الأخيرة بتجربة البحث عن أسمائنا عبر بوتات الدردشة. يمكن تبرير المخرجات أحياناً بتشابه الأسماء مع شخصيات عامة، لكن غير ذلك ما تقدّمه مجرد اختلاق. وليست هذه المرة الأولى التي يقود تقديم تشات جي بي تي معلومات خاطئة عن أشخاص أوبن أيه آي إلى أروقة المحاكم:

- في أبريل من عام 2024، رفعت نويب دعوى قضائية ضد أوبن أيه آي ممثلة شخصية عامة نمساوية (لم تفصح عن اسمها)، قالت فيها هذه الشخصية إن بوت الدردشة ولّد معلومات خاطئة تتعلق بتاريخ ميلاده.

- في أغسطس من عام 2023، رفع المحامي لوكاس أوليينيك من هيئة حماية البيانات البولندية دعوى على أوبن أيه آي مكونة من 17 صفحة، قال فيها إن شعوراً بالقلق قد ساوره بعد استخدام بوت الدردشة تشات جي بي تي لإنشاء سيرة ذاتية لنفسه قدّم فيها البوت معلومات غير دقيقة عنه.

- في أبريل من عام 2023، هدد رئيس البلدية الأسترالي، برايان هوود، بمقاضاة شركة أوبن أيه آي، بعد أن نشر تشات جي بي تي معلومات خاطئة عنه تتهمه بأنه أُدين في قضية رشوة وفساد، حيث زعم تشات جي بي تي أن هوود قد تورط في فضيحة رشوة في أثناء عمله في شركة Note Printing Australia، وهي شركة تابعة للبنك الاحتياطي الأسترالي، وأنه قضى عقوبة بالسجن مدة 30 شهراً. لكن الحقيقة هي أن هوود كان المُبلّغ عن الفساد في القضية ولم يتهمه أو يُدينه بأي جريمة.

- رفع مارك والترز، وهو مقدم إذاعي أميركي، دعوى قضائية ضد أوبن أيه آي بعد أن زعم تشات جي بي تي بأنه متورط في اختلاس أموال من منظمة حقوق حمل السلاح Second Amendment Foundation. كانت المعلومات ملفقة بالكامل، بما في ذلك تفاصيل القضية ورقمها القانوني.

- رُبِطت صورة المذيع ديف فانيغ خطأً بقصة إخبارية عن مذيع آخر متهم بجرائم جنسية. يُعتقد أن خطأً في أداة ذكاء اصطناعي لتجميع الأخبار كان السبب.

- عند استخدام كوبايلوت، اكتشف الصحفي الألماني مارتن بيرنكلاو اكتشافاً صادماً عندما أدخل اسمه في أداة الذكاء الاصطناعي "كوبايلوت" من مايكروسوفت، حيث قالت إنه متحرش بالأطفال، يبلغ من العمر 54 عاماً، وأفادت معلومات الذكاء الاصطناعي بأن بيرنكلاو اعترف بالجريمة وأنه نادم. ووصفته أداة الذكاء الاصطناعي أيضاً بأنه هارب من مؤسسة نفسية، ومحتال يستهدف الأرامل، وتاجر مخدرات، ومجرم عنيف.

اقرأ أيضاً: كيف يؤدي الذكاء الاصطناعي التوليدي إلى تفاقم انتشار المعلومات المزيفة والدعاية المغرضة؟

مدى خطورة المشكلة

إن تقديم نماذج اللغات الكبيرة معلومات خاطئة عن الأفراد يشكّل خطراً كبيراً لعدة أسباب:

- الإضرار بالسمعة والمسؤولية القانونية: كما حدث في كثيرٍ من الأمثلة السابقة، حتى في حالة هولمن نفسه. وهنا يطول ذلك الجانبين، حيث تُسيء هذه المعلومات إلى سمعة الأشخاص، وتضع الشركة أيضاً موضع اتهام ومساءلات قانونية، مع ما يرافق ذلك من خسائر مهنية واجتماعية.

- صعوبة تصحيح المعلومات الخاطئة: بمجرد نشر معلومات خاطئة عبر منصات تعتمد على الذكاء الاصطناعي، يصعب تصحيحها بسبب سرعة انتشارها واعتماد النماذج على بيانات قديمة أو مُتحيزة. وقد توصلت دراسة من جامعة زيورخ، نُشِرت عام 2024 إلى أن دقة نماذج مثل جي بي تي-4 في التحقق من الحقائق تتراوح بين 64% و71% فقط، ما يترك هامشاً كبيراً للأخطاء، كما أن عملية التصحيح عبر بوت الدردشة غير ممكنة، وتطلب تصحيح المعلومات جولة طويلة من المراسلات.

- تعزيز التحيزات المجتمعية: إذا كانت البيانات المُستخدمة في تدريب النماذج تحتوي على تحيزات، فقد تكرر النماذج هذه التحيزات عند الحديث عن أفراد أو مجموعات. قد يؤدي هذا إلى حرمان الأفراد من فرص عمل بناءً على معلومات مُتحيزة ناتجة عن تدريب نماذج الذكاء الاصطناعي.

- تهديد الثقة في المصادر الرقمية: من خلال خداع المستخدمين عبر تصميم نماذج مثل تشات جي بي تي لتبدو "واثقة" و"مُقنعة" حتى عندما تكون معلوماتها خاطئة. هذا يجعل المستخدمين العاديين يثقون بها كمرجع موثوق، دون معرفة حدودها. في حالة هولمن، تضمنت مخرجات تشات جي بي تي الكثير من المعلومات الصحيحة عنه، كمكان سكنه، وعدد أطفاله، ما يوحي فعلاً بأن النماذج مخرجاتها صحيحة.

- استغلالها لنشر المعلومات المضللة عمداً: يمكن للمتسللين تسميم بيانات التدريب أو التلاعب بالنماذج لتوليد معلومات كاذبة عن أشخاص، مثل اتهامهم بجرائم وهمية.

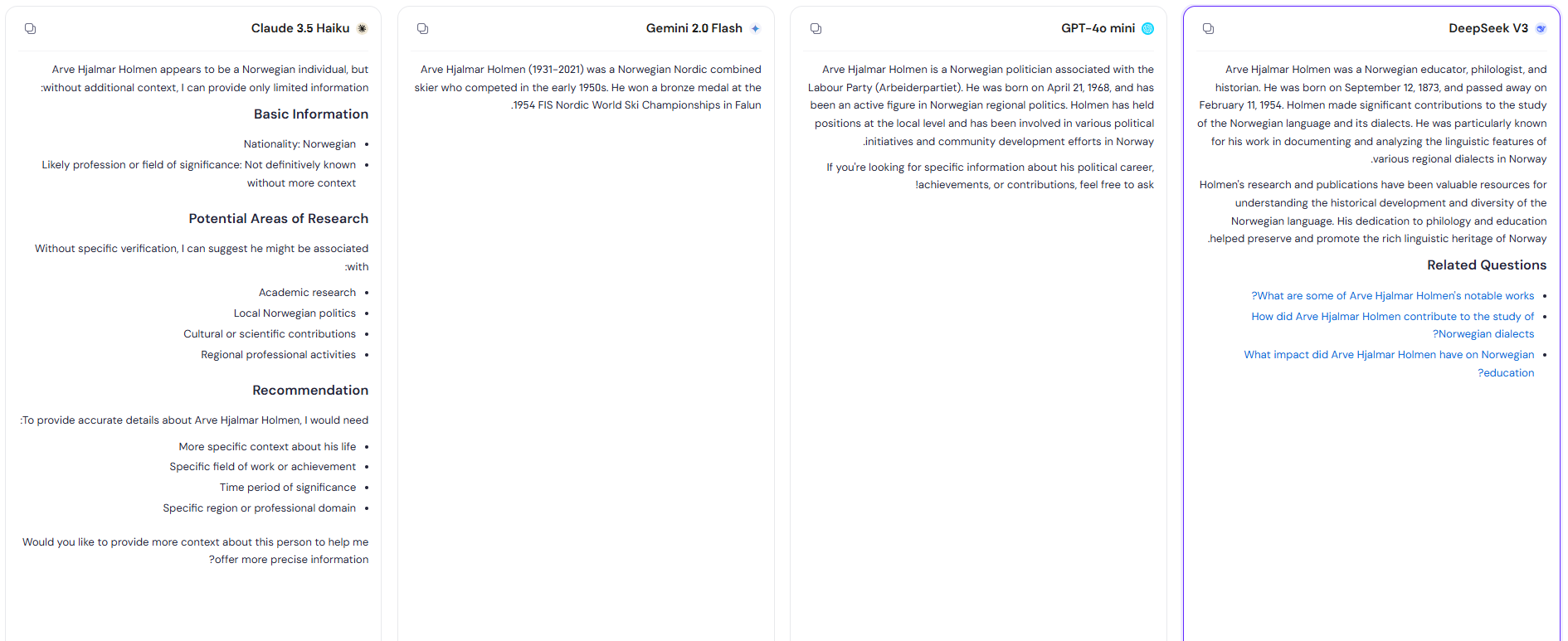

بالمناسبة، عند إعادة البحث عن هولمن، كانت نتائج البحث كما هي موضحة في الصورة المرفقة، والتي توضّح إجماع النماذج اللغوية على أنه رجل نرويجي، لكن يعطي كل نموذج من النماذج وصفاً خاصاً به. ولا بُدّ أن نُعجب بإجابة كلود التي كانت الأقل حسماً بين الإجابات، وبطريقة أو بأخرى تقدّم دليلاً للمستخدم على أن النموذج اللغوي لم يتوصل إلى نتيجة حاسمة.

في حالة هولمن أيضاً، وفي حال أردنا التحقق من شخصية الذي نبحث عنه، كانت نتائج البحث على جوجل -حتى الصفحة الرابعة- كلها مرتبطة بحادثة تشات جي بي تي، أي أننا وفي حالة شخص ربما وُجد يوماً ما، وكان يحمل صفة من التي اختلقتها بوتات الدردشة، فقدنا أثره الصحيح على الإنترنت، إلّا فيما يرتبط بهولمن والحادثة الأخيرة.

اقرأ أيضاً: أبرز بوتات الدردشة التي قد تقدم معلومات مضللة عند استخدامها

هل نتائج الاستفسار في بوتات الدردشة عن الأشخاص دقيقة؟ ولماذا؟

إذا لم يكن الشخص أشهر من نار على علم، فالإجابة الدقيقة هي لا. لكن بالطبع تختلق بوتات الدردشة قصصاً كثيرة، وسير ذاتية مزيفة عن الأشخاص، على الرغم من تقييد الكثير من النماذج اللغوية لوصول بوتات الدردشة إلى المعلومات الشخصية، وتزويدها بإعدادات تمكّن الشخص من تحديد المعلومات التي يمكنه أن يشاركها معها. لذلك يجب توخي الحذر المضاعف عند البحث عن الأشخاص باستخدامها.

تعود النتائج الخاطئة التي يمكن أن تولّدها بوتات الدردشة عن الأشخاص إلى الأسباب التالية:

- الهلوسة: تعود إلى طبيعة بناء النماذج اللغوية التي صُمِّمت لتكمل النصوص بناءً على البيانات التي دُرِّبت عليها، وتولّدها بثقة وبطريقة قد تبدو منطقية، ما يدفع المستخدمين إلى تصديقها.

- قيود بيانات التدريب: يعتمد تشات جي بي تي على بيانات قديمة دُرِّبت عليها، كما لا يمكنه الوصول إلى تحديثات معلومات الأشخاص في الزمن الحقيقي لتقديم إجابات دقيقة عن الأشخاص الذين يتم الاستفسار عنهم.

- طبيعة الاستفسار: الأفضل أن تسأل أسئلة واقعية تتضمن منصب الأشخاص، ومعلومات معروفة عنهم، أو مرتبطة بهم، مثلاً الأفضل أن تسأل "مَن صاحب أول قناة يوتيوب؟" أو "مَن هو الرئيس الرابع للولايات المتحدة؟"، بدل أن تكون الاستعلامات عن اسم عشوائي في عالم يقطنه 8 مليارات نسمة!

اقرأ أيضاً: كيف تحمي نفسك من المعلومات العلمية المزيفة التي تنشئها نماذج الذكاء الاصطناعي التوليدي؟

توصيات للحد من المخاطر

في البداية، يجب توخي أقصى درجات الحذر بشأن الخصوصية عند استخدام الإنترنت، فبياناتك المنتشرة عبر الإنترنت قد تجد طريقها إلى البيانات المستخدمة في تدريب بوتات الدردشة وما يترتب على ذلك من نتائج. بالإضافة إلى أنه يجب ألّا تشارك الكثير من المعلومات الشخصية مع بوتات الدردشة، فهي وسائل لتساعدك على الإنتاجية وليست صديقاً لك. المشكلة ليست في الأخطاء العرضية، بل في الطبيعة الاحتمالية لنماذج الذكاء الاصطناعي التي تجعلها عُرضة لتكرار الأكاذيب أو اختلاقها، ما يُهدد الأفراد والمجتمعات إذا لم تُدار بحذر.

كما يمكن مراعاة النقاط التالية:

- توضيح حدود النماذج: إضافة تحذيرات بأن مخرجاتها قد تكون غير دقيقة، وهذه الخطوة تكون من قِبل الشركات التي تشغل البوتات، لكن على المستخدم أن يعي الأمر جيداً، وبأن هذا التوضيح لا يعفي الشركات من مسؤوليتها تجاه الأضرار التي قد تسببها.

- التحقق البشري: استخدام النماذج كأدوات مساعدة فقط، مع ضرورة مراجعة المخرجات من مصادر متنوعة، وحتى هذه الخطوة -كما في حالة هولمن- فقدت فاعليتها، يتبقى الاتصال بالدائرة المحيطة بالشخص، أو بالشخص نفسه. المشكلة تظهر إذا كان الفرد قد عاش في فترة سابقة -أو لم يوجد ربما- فقد تهدد بوتات الدردشة بهلوساتها هذه باختلاق تاريخ كامل ملفق عنه.

- تنظيم استخدامها: حظر استخدامها في المجالات الحساسة مثل الطب أو القضاء أو البحث عن الأشخاص الذين يقدمون طلبات توظيف أو غيرها.

- تحسين الشفافية: الإفصاح عن مصادر البيانات وآليات اتخاذ القرار داخل النماذج.

اقرأ أيضاً: كيف تتمكن الشركات المشبوهة من تخمين معلوماتك الشخصية الخاصة؟

إذا حدث وكنت -أو أحد تعرفه- ضحية لمخرجات خاطئة من تشات جي بي تي، فيمكنك من خلال هذه الصفحة مراسلة أوبن أيه لتصحيح المعلومات أو إزالتها، ووفق البوت الذي تستخدمه، تقدّم كل شركة عنوان بريد إلكتروني للتواصل في أمور الخصوصية.