يمكن في الوقت الحالي إنتاج فيديوهات بواسطة الذكاء الاصطناعي تُظهِر دونالد ترامب وهو يقول كلاماً أو يفعل أمراً فظيعاً وتحريضياً للغاية، ولا تستبعد أيضاً أن يكون الفيديو معقولاً للغاية وقابلاً للتصديق. وفي أسوأ الحالات سيتسبب هذا الفيديو في التأثير على الانتخابات، أو قَدْح شرارة العنف في شوارع أميركا، أو إشعال نزاع دوليّ مسلّح.

ولحسن الحظ، ظهرت للوجود الآن تقنية رقمية جديدة في مجال الكشف عن الجرائم تَعِد بحماية الرئيس ترامب -وغيره من قادة العالم والمشاهير- من مثل هذه التزييفات العميقة، على الأقل للوقت الحالي. هذه التقنية الجديدة تستخدم التعلمَ الآلي لتحليل الأسلوب المميِّز لكلام المرء وحركته، أو ما يسميه الباحثون "التوقيع البيومتري الناعم".

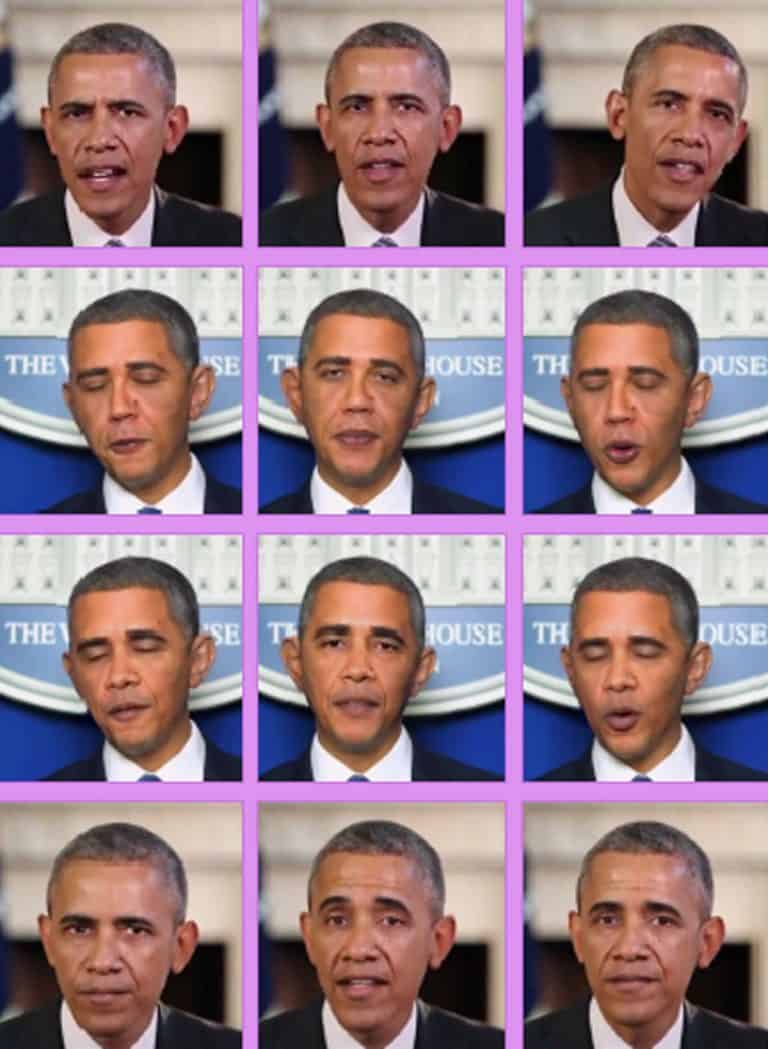

وفي هذا السياق، استخدم الباحثون، من جامعة كاليفورنيا في بيركلي وجامعة جنوب كاليفورنيا، أداةً موجودة من قبل لاستخراج حركات الوجه والرأس التي يقوم بها الأفراد عفوياً. ومن ناحية أخرى، أنشؤوا فيديوهات مزيفة لكل من دونالد ترامب، وباراك أوباما، وبيرني ساندرز، وإليزابيث وارِن، وهيلاري كلينتون، مستخدمين في ذلك الشبكات التوليدية التنافسية (GANs)، وهي عبارة عن بنى خاصة تضم شبكتين عصبيتين عميقتين تتنافسان فيما بينهما.

بعد ذلك استخدم الفريق التعلم الآلي للتعرف على حركات الرأس والوجه التي تميّز الشخص الحقيقيّ. والخبر السعيد أن هذه العلامات الدقيقة -مثل الطريقة التي يومئ بها بيرني ساندرز عند تلفظه بكلمة معينة، أو الطريقة التي يبتسم بها ترامب بتكلف بعد إجابته عن أحد الأسئلة- لم تتم نمذجتها حالياً في خوارزميات التزييف العميق.

وبعد إجراء التجارب على هذه التقنية الجديدة، وجدوا أنها تتمتع بنسبة دقة قدرها 92% في اكتشاف زيف العديد من أنواع فيديوهات التزييف العميق، من بينها تلك التي تُبدِّل الوجه فحسب، وتلك الفيديوهات التي يستخدم فيها المُزيِّف دميةً رقمية. كما تمكنت هذه التقنية أيضاً من التعامل مع أخطاء الملفات التي عادةً ما تُخلّفها عملية إعادة ضغط الفيديو، وهي بقايا رقمية غالباً ما تُربك تقنيات الكشف الأخرى.

وفي الوقت الراهن، يخطط الباحثون لتحسين التقنية من خلال الاهتمام بخصائص خطاب الشخص كذلك. ويُذكر أن هذه الدراسة -التي قُدّمت في مؤتمر خاص برؤية الحاسب انعقد في كاليفورنيا هذا الأسبوع- مُوِّلت من قِبل كل من شركة جوجل ووكالة داربا البحثية التابعة للبنتاجون. وحريٌّ بالذكر أيضاً أن داربا تموّل برنامجاً هدفه ابتكار تقنيات لكشف التزييف أفضل من الموجودة حالياً.

وتتمثل المشكلة التي تواجه قادة العالم حالياً (وبطبيعة الحال أي شخص آخر) في أنه أصبح من السهل جداً إنشاء فيديوهات مزيفة باستخدام الذكاء الاصطناعي. وهذه المشكلة ليست مستقبلية، بل واقعة بالفعل؛ فالأخبار الصحفية المضللة، والحسابات المزيفة على الشبكات الاجتماعية، والفيديوهات المعدّلة، قامت جميعها بتقويض وإضعاف الأخبار السياسية الحقيقية وخطابات الشخصيات الدولية. وفي الوقت الراهن، ينتاب العديد من السياسيين قلقٌ بالغ من استطاعة بعض الجهات استخدامَ الإعلام المزيف لبثِّ معلومات مضللة أثناء إجراء الانتخابات الرئاسية الأميركية للعام 2020.

صحيح أن هناك بالفعل بعض الأدوات المصممة بشكل خاص لكشف الفيديوهات المزيفة، إلا أن المزورين يُحدّثون أساليبهم بسرعة للتغلب على هذه الأدوات. ولنأخذ مثالاً على ذلك، حيث كان من الممكن حتى وقت قريب اكتشاف التزييف العميق من خلال تتبع حركات عين المتحدث، التي كانت تبدو حركات غير طبيعة في الفيديوهات المزيفة. لكن بعد فترة قصيرة فقط من اكتشاف هذه الطريقة، ضبط المزيِّفون خوارزميات التزييف العميق لتتضمن حركات عيونٍ أكثر طبيعية.

يقول هاو لي، الأستاذ بجامعة جنوب كاليفورنيا والرئيس التنفيذي لشركة بينسكرين (Pinscreen)، والذي كان له يد في تطوير هذه التقنية الجديدة: "إننا نشهد الآن سباقاً محموماً بين فريق التلاعب الرقمي وفريق الكشف عن ذلك التلاعب. والتطورات التي تشهدها الخوارزميات القائمة على الذكاء الاصطناعي تؤجِّج الحرب بينهما، وتحث كِلا الطرفين على التقدم أكثر". ولهذا السبب بالذات، لم يُصدر فريق الأستاذ هاو لي حتى الآن الكودَ البرمجي الذي تقوم عليه هذه التقنية الجديدة للكشف.

ومع أنه يقول إن من الصعب أن يتغلب المزيِّفون وصانعو الفيديوهات المضللة على هذه التقنية الجديدة، إلا أنه يعترف بأنهم سيتمكنون من ذلك في نهاية المطاف. حيث يقول: "إن طريقة المزيفين لتجاوز هذه التقنية من الوارد أن تتم بواسطة تكوين الحركات والسلوكيات بناءً على فيديوهات حقيقية سابقة لذلك الشخص المُراد تزييف الفيديوهات عنه".

كما يشير أيضاً إلى أنه قد أصبح لزاماً على الجميع أن يحمي نفسه من فيديوهات التزييف العميق؛ نظراً لتطور صناعتها وكونها أصبحت أسهل وأجود نوعية. ويختتم كلامه بقوله: "إن المشاهير والشخصيات السياسية هي الفئات المستهدفة حالياً، لكن لن يأخذني العجب، إن عرفت أنه خلال عام أو عامين من الآن سيصبح في متناول الجميع أن يزيفوا أي فيديو بصورة لا يمكن تمييزها عن الحقيقة".